大小|patch成为了ALL You Need?挑战ViT、MLP-Mixer的简单模型来了( 二 )

还有网友表示:「作为消融实验 , 我认为很有趣 。 我不认为这篇论文的目的是表达『 ConvMixer 是一个好的架构 , 值得研究者使用』 , 而是『这个简单的架构有效的帮助我们缩小了其他模型最有价值的特性范围』 。 」

文章图片

一个简单的模型:ConvMixer

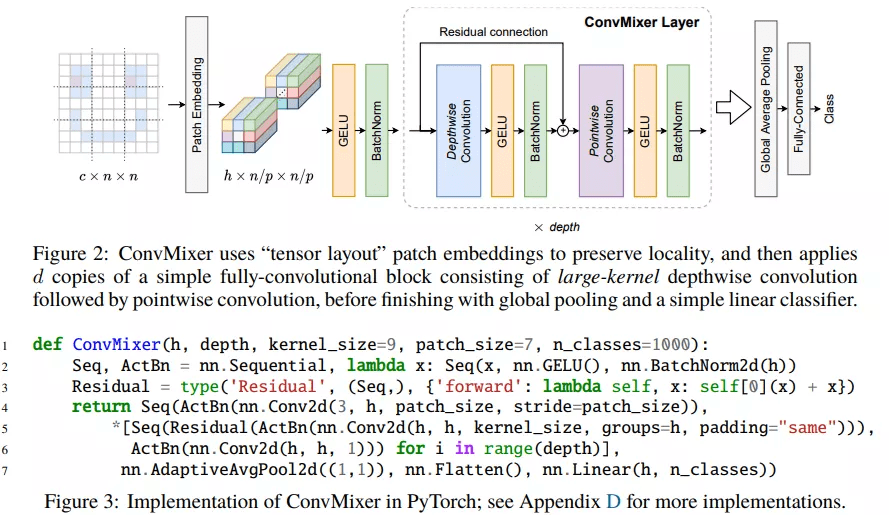

ConvMixer 由一个 patch 嵌入层和一个简单的全卷积块的重复应用组成 。 该研究保持 patch 嵌入的空间结构 , 如下图 2 所示 。 patch 大小为 p 和嵌入维度为 h 的 patch 嵌入可以实现具有 c_in 输入通道、h 个输出通道、内核大小 p 和步长 p 的卷积:

文章图片

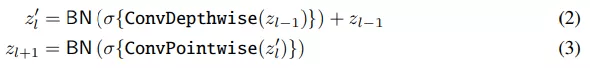

ConvMixer 块本身由 depthwise 卷积(即组数等于通道数 h 的分组卷积)和 pointwise(即内核大小为 1 × 1)卷积组成 。 每个卷积之后是一个激活函数和激活后的 BatchNorm:

文章图片

在 ConvMixer 块的多次应用之后 , 执行全局池化以获得大小为 h 的特征向量 , 并将其传递给 softmax 分类器 。

设计参数:ConvMixer 的实例化取决于四个参数:(1)宽度或隐藏维度 h(即 patch 嵌入的维度) , (2)深度 d , 或 ConvMixer 层的重复次数 , (3 ) 控制模型内部分辨率的 patch 大小 p ,(4) 深度卷积层的内核大小 k 。 研究者根据它们的隐藏维度和深度命名 ConvMixers , 如 ConvMixer-h/d 。 他们将原始输入大小 n 除以 patch 大小 p 作为内部分辨率;但是请注意 , ConvMixers 支持可变大小的输入 。

动机:ConvMixer 架构基于混合思想 。 具体地 , 该研究选择了 depthwise 卷积来混合空间位置 , 选择 pointwise 卷积来混合通道位置 。 先前工作的一个关键思想是 MLP 和自注意力可以混合较远的空间位置 , 即它们可以具有任意大的感受野 。 因此 , 该研究使用较大的内核卷积来混合较远的空间位置 。

实验结果

研究者首先在 CIFAR-10 上执行了小规模的实验 , 其中 ConvMixers 仅使用 0.7M 的参数实现了 96% 以上的准确率 , 验证了卷积归纳偏置的数据高效性 。

此外 , 研究者不使用任何预训练或额外数据 , 在 ImageNet-1k 分类数据集上对 ConvMixers 进行了评估 。 他们将 ConvMixer 添加到 timm 框架中 , 并使用近乎标准的设置进行训练 , 包括默认 timm 增强、RandAugment、mixup、CutMix、随机删除(random erasing)和梯度标准裁剪 。

研究者还使用了 AdamW 优化器和一个简单的 triangular 学习速度时间表 。 由于计算受限 , 他们没有在 ImageNet 上进行超参数调整 , 并较竞品模型训练了更少的 epoch 。

推荐阅读

- 快报|“他,是能成就导师的学生”

- 地面|全程回顾神舟十三号航天员乘组圆满完成第二次出舱任务

- 最新消息|中围石油回应被看成中国石油:手续合法 我们看不错

- 人物|马斯克谈特斯拉人形机器人:有性格 明年底或完成原型

- 测试|图森未来完成全球首次无人驾驶重卡在公开道路的全无人化测试

- AMD|AMD 350亿美元收购赛灵思交易完成时间推迟 预计明年一季度完成

- 网络化|工信部:2025年建成500个以上智能制造示范工厂

- Apple|苹果高管解读AirPods 3代技术细节 暗示蓝牙带宽可能成为瓶颈

- 智能化|龙净环保:智能型物料气力输送系统的研究及应用成果通过鉴定

- 识别|天津滨海机场RFID行李全流程跟踪系统完成建设 行李标签识别成功率可提升至99%