技术|华为诺亚Transformer后量化技术:效率百倍提升,视觉&NLP性能不减( 四 )

文章图片

随着迭代次数 t 进行线性缩减 。

实验验证

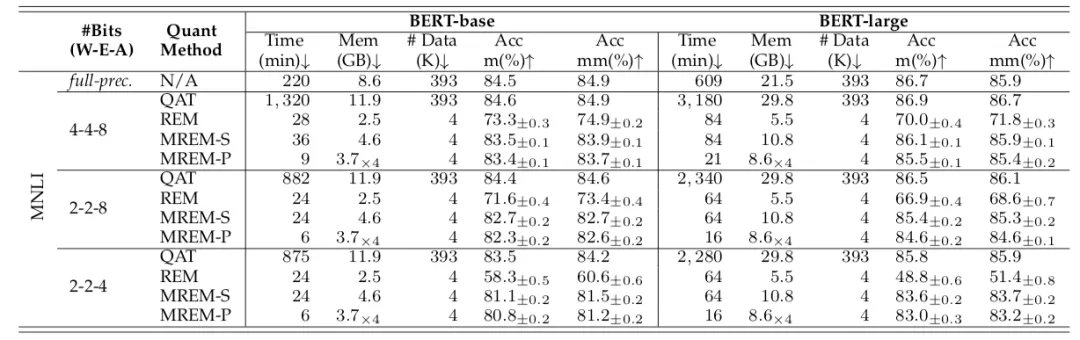

研究者首先在 MNLI 数据集上进行验证 。 由下表可以发现 , 对比逐层后量化训练(REM)算法 , 提出的逐模块量化误差重构 (MREM-S)大大提升了后量化的准确率;同时 , MREM-S 性能也可以接近量化感知训练(QAT)的方法 , 对于 BERT-base 和 BERT-large 在 W4A8 的设定下仅仅比 QAT 低了 1.1% 和 0.8% , 训练时间、显存开销和数据消耗也有了减小 。

当结合并行知识蒸馏时(MREM-P) , 后量化训练时间可以进一步缩短 4 倍 , 而且没有明显性能损失 。 例如 , MREM-P 仅耗时 6 分钟 , 占用 3.7GB 即可完成 BERT-base 上 2 比特权重的后量化训练 。

文章图片

在 MNLI 上与 QAT 和 REM 的对比 。

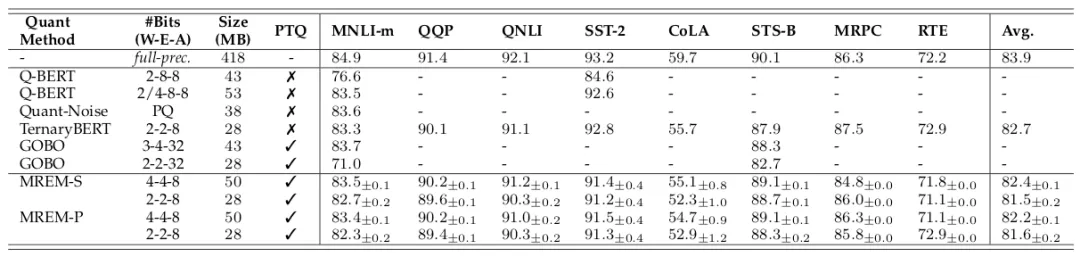

研究者同时在 GLUE 上与现有的其他算法进行了对比 。 如下表所示 , 本文的方法 (MREM-S 和 MREM-P) 比后量化方法 GOBO【4】取得更好的效果 , 甚至在多个任务上接近量化感知训练方法 TernaryBERT 。

文章图片

在 GLUE 公开数据集上与现有方法对比 。

参考文献:

【1】Di Wu, Qi Tang, Yongle Zhao, Ming Zhang, Ying Fu, and Debing Zhang. Easyquant: Posttraining

quantization via scale optimization. arXiv preprint arXiv:2006.16669, 2020.

【2】Peisong Wang, Qiang Chen, Xiangyu He, and Jian Cheng. Towards accurate post-training

network quantization via bit-split and stitching. In International Conference on Machine

Learning, pages 9847–9856. PMLR, 2020.

【3】I. Hubara, Y. Nahshan, Y. Hanani, R. Banner, and D. Soudry, “Improving post training neural quantization: Layer-wise calibration and integer programming,” in Proceedings of the International Conference on Machine Learning, 2021.

【4】A. H. Zadeh, I. Edo, O. M. Awad, and A. Moshovos, “Gobo: Quantizing attention-based nlp models for low latency and energy efficient inference,” Preprint arXiv:2005.03842, 2020.

推荐阅读

- 生物|两项国家标准发布实施 为畜禽生物育种提供技术参考

- IT之家|华为nova系列4G新机入网图公布:6.78英寸LCD屏,1.08亿像素主摄

- 该机|华为 nova 系列 4G 新机入网图公布:6.78 英寸 LCD 屏

- 财产|折叠屏手机冲击高端,荣耀从华为继承的最后财产

- 俄罗斯|22岁天才少女加入华为俄罗斯研究院,曾获「编程界奥赛」冠军

- 平台|韩国科学技术研究院开发出世界首款 AI 运算专用 SSD

- 爆发|从1G到5G 技术成熟与应用爆发相辅相成

- 技术|Magic V正式发布,一部难到位,荣耀的高端之路刚刚开始

- 关键特性|5G超级频率聚变技术成功纳入3GPP R18标准立项

- 专利技术|抗幽别听忽悠