机器之心专栏

作者:孙建新

该方法首次实现多个文本输入的人脸合成 , 与单输入的算法相比生成的图像更加接近真实人脸 。文本人脸合成指的是基于一个或多个文本描述 , 生成真实自然的人脸图像 , 并尽可能保证生成的图像符合对应文本描述 , 可以用于人机交互 , 艺术图像生成 , 以及根据受害者描述生成犯罪嫌疑人画像等 。 针对这个问题 , 中科院自动化所联合北方电子设备研究所提出了一种基于多输入的文本人脸合成方法(SEA-T2F) , 并建立了第一个手工标注的大规模人脸文本描述数据集(CelebAText-HQ) 。 该方法首次实现多个文本输入的人脸合成 , 与单输入的算法相比生成的图像更加接近真实人脸 。 相关成果论文《Multi-caption Text-to-Face Synthesis: Dataset and Algorithm》已被ACM MM 2021录用 。

文章图片

- 论文地址:https://zhaoj9014.github.io/pub/MM21.pdf

- 数据集和代码已开源:https://github.com/cripac-sjx/SEA-T2F

文章图片

图1 不同方法的文本到人脸图像生成结果

相较于文本到自然图像的生成 , 文本到人脸生成是一个更具挑战性的任务 , 一方面 , 人脸具有更加细密的纹理和模糊的特征 , 难以建立人脸图像与自然语言的映射 , 另一方面 , 相关数据集要么是规模太小 , 要么直接基于属性标签用网络生成 , 目前为止 , 还没有大规模手工标注的人脸文本描述数据集 , 极大地限制了该领域的发展 。 此外 , 目前基于文本的人脸生成方法[1,2,3,4]都是基于一个文本输入 , 但一个文本不足以描述复杂的人脸特征 , 更重要的是 , 由于文本描述的主观性 , 不同人对于同一张图片的描述可能会相互冲突 , 因此基于多个文本描述的人脸生成具有很重大的研究意义 。

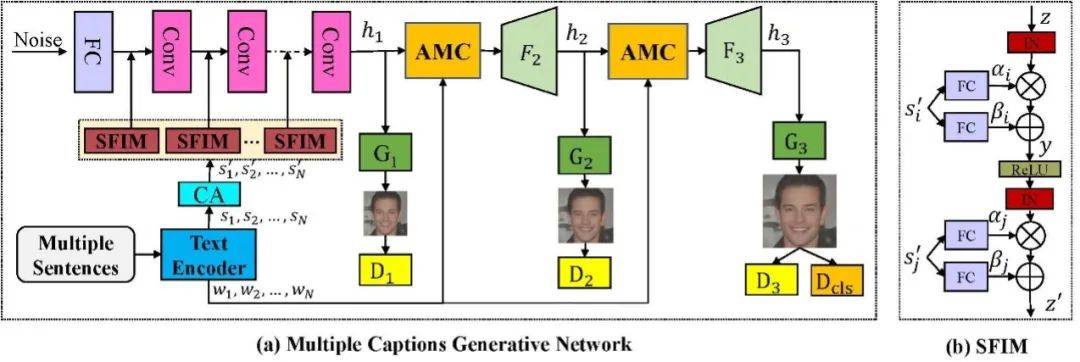

针对该问题 , 团队提出了一个基于多输入的文本人脸生成算法 。 算法采用三阶段的生成对抗网络框架 , 以随机采样的高斯噪声作为输入 , 来自不同文本的句子特征通过SFIM模块嵌入到网络当中 , 在网络的第二第三阶段分别引入了AMC模块 , 将不同文本描述的单词特征与中间图像特征通过注意力机制进行融合 , 以生成更加细密度的特征 。 为了更好地在文本中学习属性信息 , 团队设计了一个属性分类器 , 并引入属性分类损失来优化网络参数 。

文章图片

图2 模型框架示意图

推荐阅读

- 人脸|“骁龙870版”小米12:小米12X发布:3199元起

- 人脸信息|如何护住我们的“脸”

- 犯罪学|人脸识别有易破解隐患 准确定罪存在一定争议

- 人脸|部分商家热衷“盗采”消费者人脸信息,怎么破?

- 材料|中科院成功研制出 4D 打印血管支架

- 青少年|中科院老科学家科普演讲走进三亚中小学校

- 重整|中科院 3D 打印制备车载甲醇重整制氢催化剂研究取得新进展

- 风险|中科院院士王建宇:商业航天很火但风险也比较大

- 轻喜剧|中科院物理所推出科普轻喜剧《闹起来,费先生》

- 技术|中科院成都分院启动入驻成都科学城