机器之心报道

编辑:小舟

许多人质疑量子数据能否变得高度可用 , 来自洛斯阿拉莫斯国家实验室(LANL)和伦敦大学的一项研究证明量子卷积神经网络(QCNN)具备巨大的潜力 。随着量子计算机的出现给计算机领域带来了许多突破性进展 。 在量子计算机上运行的卷积神经网络也因其比经典计算机更好地分析量子数据的潜力而引起诸多关注 。 量子神经网络(QNN)被认为是最有前途的架构之一 , 其应用包括物理模拟、优化等 。

尽管 QNN 具有巨大的潜力 , 但许多 QNN 架构已被证明会出现「贫瘠高原」现象 , 其中代价函数的梯度随系统大小呈指数级消失 , 使得 QNN 架构无法针对大型问题进行训练 。

近日 , 来自美国洛斯阿拉莫斯国家实验室(LANL)和伦敦大学的研究人员构建了一个不存在贫瘠高原的特定 QNN 架构 。 该研究的论文《Absence of Barren Plateaus in Quantum Convolutional Neural Networks》在《PHYSICAL REVIEW X》上发表 。

文章图片

论文地址:https://journals.aps.org/prx/pdf/10.1103/PhysRevX.11.041011

近来一些研究者提出了量子卷积神经网络(QCNN)架构 , 洛斯阿拉莫斯国家实验室(LANL)和伦敦大学的这项研究严格分析了 QCNN 架构中参数的梯度缩放 。 该研究发现梯度的方差消失的速度并没有比多项式更快 , 这意味着 QCNN 没有出现贫瘠高原现象 。 该结果为随机初始化的 QCNN 的可训练性提供了分析保证 , 这突出了 QCNN 与许多其他 QNN 架构的不同 , 即在随机初始化下可训练 。

避免梯度消失问题

该研究为了得出其分析结果 , 提出了一种基于图的新方法来分析 Haar 分布式 unitary 的期望值 , 这可能是一种极为有效的方法 。 最后 , 该研究用数值模拟验证了其分析结果 。

QCNN 架构

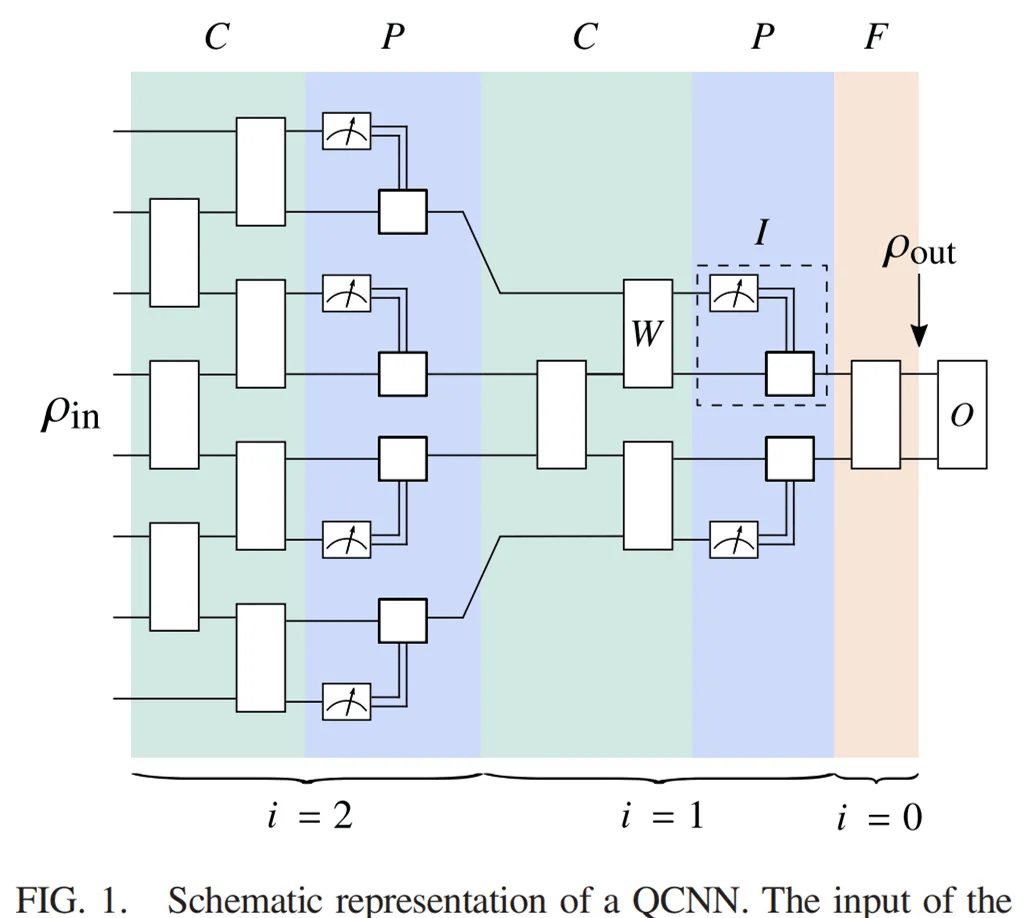

QCNN 架构涉及一系列卷积层和池化层 , 这些层减少了量子比特的数量 , 同时保留了有关数据特征的信息 。

如下图 1 所示 , QCNN 架构将 Hilbert 空间 H_in 中的 n-qubit 输入状态 ρ_in 作为输入 , 该状态通过由一系列卷积层和池化层组成的电路发送 。 卷积层由两行参数化的双量子比特门组成 , 作用于相邻量子比特的 alternating 对 。 在每个池化层中 , 测量一半的量子比特 , 测量结果控制应用于相邻量子比特的 unitary 。 在 L 个卷积层和池化层之后 , QCNN 中还包含一个全连接层 , 该层对剩余的量子比特应用 unitary 。 最后测量一些 Hermitian 算子 O 的期望值 。

文章图片

QCNN 架构示意图 。

该研究将 QCNN 的输入状态映射到 Hilbert 空间中的一个缩减状态 , 其中 H_out 的维度远小于 H_in 的维度 。 输出状态可以表示为:

推荐阅读

- 网络|天津联通全力助推天津市入选全国首批千兆城市

- 网络化|工信部:2025年建成500个以上智能制造示范工厂

- 视点·观察|张庭夫妇公司被查 该怎样精准鉴别网络传销?

- 最新消息|宝马LG和其他公司正考虑使用量子计算机解决具体问题

- 器件|6G、量子计算、元宇宙…上海市“十四五”聚焦这些前沿领域

- 前瞻|6G、量子计算、元宇宙……上海市“十四五”聚焦这些前沿新兴领域

- 数字化|70%规模以上制造业企业到2025年将实现数字化、网络化

- 人物|俄罗斯网络博主为吸引流量 闹市炸毁汽车 结果够“刑”

- 协同|网文论︱网络文学与AI写作:人机协同演化时代的文学之灵

- 周鸿祎|网络安全行业应提升数字安全认知