MLP-Mixer|44种模型、1200种子网,RobustART评测CNN、Transformer、MLP-Mixer谁最鲁棒?( 二 )

RobustART 将作为核心组成部分 , 整合到北航团队先前研发的人工智能算法与模型安全评测环境「重明」 系统当中 , 并发布「重明」2.0 版本(「重明」 是国内领先的智能安全评测环境 , 曾受邀在国家新一代人工智能开源社区 OpenI 启智开源开放平台发布 , 并荣获 OpenI 社区优秀开源项目) 。 在未来 , RobustART 将持续为整个社区提供更加完善、易用的开源鲁棒性评估和研究框架 。 同时也将助力于工业级模型的评测和鲁棒模型的落地应用 , 最终也希望能够服务于国家相关智能模型鲁棒评测标准的推进和任务的开展 。

文章图片

- 论文地址:https://arxiv.org/pdf/2109.05211.pdf

- RobustART 开源平台网址:http://robust.art/

- 重明平台网址:https://github.com/DIG-Beihang/AISafety

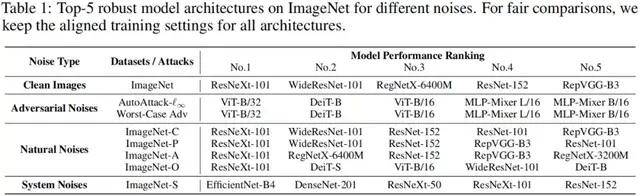

目前的鲁棒性 benchmark 主要聚焦于评估对抗防御方法的效果 , 而忽略了模型结构和训练技巧对于鲁棒性的影响 。 而这些因素对模型鲁棒性十分重要 , 一些细微的差别(如训练使用的数据增强方法的不同)就可能掩盖防御方法带来的鲁棒性影响 , 从而造成对模型鲁棒性的错误评估和认识 。 因此 , 该论文提出了 RobustART 来全面地评测不同模型结构和训练技巧对于鲁棒性的影响 , 并在对抗噪音(AutoAttack、PGD 等)、自然噪音(如 ImageNet-A, -O, -C, -P)和系统噪音(如 ImageNet-S)下进行了全面评估 。 下表给出了在研究的 44 种经典网络模型中 , 在不同噪音下鲁棒性前五名的模型(为了公平比较 , 所有模型的训练设置都已对齐):

文章图片

二、考虑模型结构和训练技巧的鲁棒性 benchmark

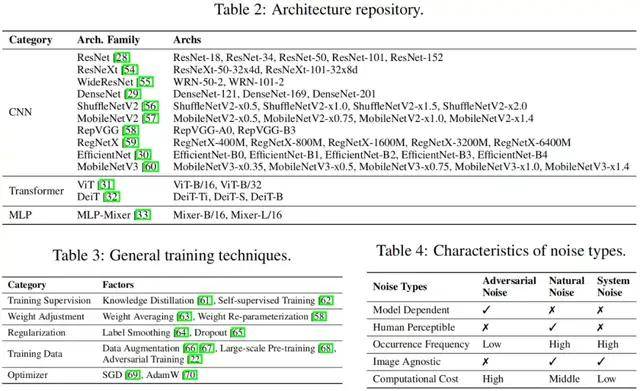

为了更好地探究模型鲁棒性的内在本质 , 该研究将影响模型鲁棒性的原因划分成模型结构和训练技巧这两个正交因素 , 进而构建了一套完整的 benchmark 设置 , 即(1)对不同网络结构的模型 , 使用同样的训练技巧进行训练(2)对于同一种网络结构的模型 , 使用不同的训练技巧进行训练 。 这种细分的消融研究更有助于人们理解某些具体的模型结构或者训练技巧对于鲁棒性的影响 。 下表分别展示了研究中用到的模型结构、训练技巧、以及噪音类型 。

文章图片

针对模型结构这一因素 , 该研究尽可能多地覆盖了常用的神经网络模型 。 对于 CNNs , 有经典的大型结构如 ResNet、ResNeXt、WideResNet、DenseNet;轻量化网络如 ShuffleNetV2、MobileNetV2;重参数化的结构 RepVGG;基于神经架构搜索(NAS)的模型如 RegNet、EfficientNet、MobileNetV3 以及使用 BigNAS 超网采样得到的子网络;对于非 CNN 网络 , 有 ViT 和 DeiT , 以及最近的基于 MLP 结构的 MLP-Mixer 。 总计 44 种典型的手工设计的网络模型和 1200 种超网采样出的子网模型 , 在实验中它们的训练设置都将被对齐 。

推荐阅读

- 模型|2022前展望大模型的未来,周志华、唐杰、杨红霞这些大咖怎么看?

- 模型|经逆向工程,Transformer「翻译」成数学框架 | 25位学者撰文

- 化纤|JXK STUDIO 虎年肥猫 1/6仿真动物模型手办可爱摆件

- 模型|达摩院2022十大科技趋势发布:人工智能将催生科研新范式

- 模型|李彦宏:中国迎来AI黄金十年,集度汽车机器人明年亮相,智能交通10年内解决拥堵

- 模型|神经辐射场去掉「神经」,训练速度提升100多倍,3D效果质量不减

- 模型|英伟达:美团机器学习平台使用NVIDIA T4 GPU

- 错误|有了这个工具,不执行代码就可以找PyTorch模型错误

- the|美国大学模型预测:全美未来两月或激增1.4亿确诊

- Samsung|三星Galaxy S22系列模型照片出现 S Pen颜色确认