识别|避免自动驾驶事故,CV领域如何检测物理攻击?(18)

攻击者还有一种攻击策略:生成一个误导热图区域(heatmap region misdirection) , 在该图中增加一个不覆盖对手区域的区域 , 以扩大捕获的区域或完全规避检测 。

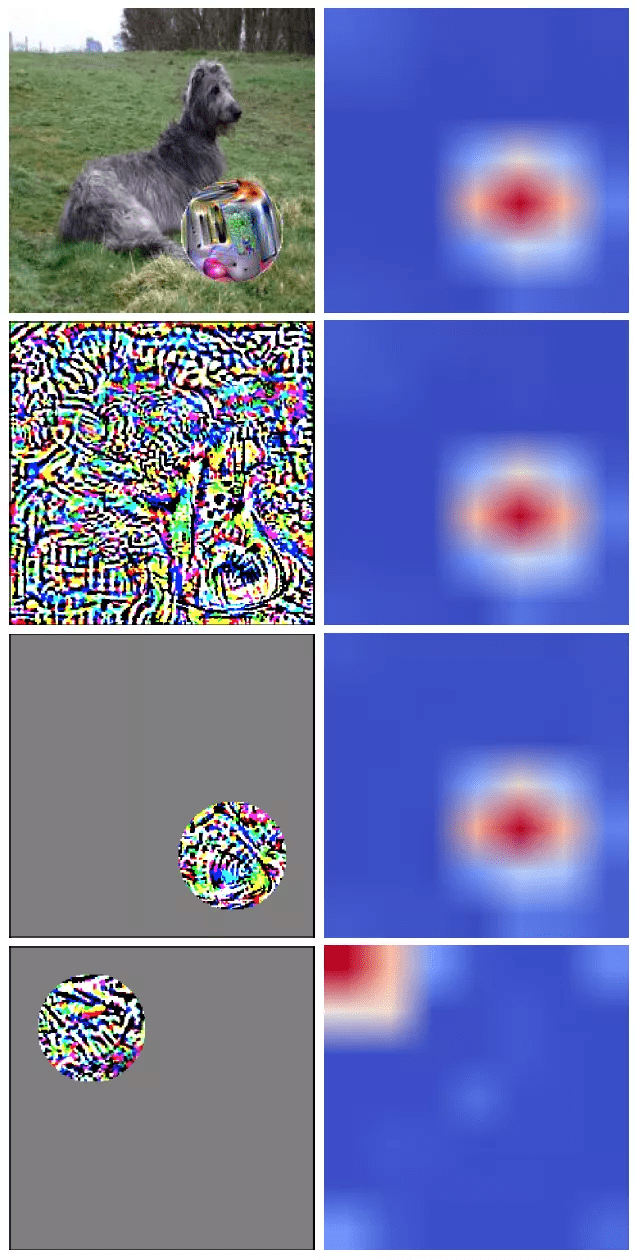

攻击者也有可能通过误导热图区域 , 即热图提出一个不包括对抗区域的区域 , 以扩大定位的区域或完全避免检测 。 但是这种操作在对手对整幅图像添加扰动噪声时会失效 , 所以作者在实验中限定攻击者不能在局部攻击区域之外添加噪声 , Grad-CAM 扰动也必须限制在对手区域中 。 因此 , 我们要考虑的威胁是攻击者可以在图像的一个区域中增加噪声 , 从而增加不相交区域中的 Grad-CAM 输出值 。 由图 13 给出的实验结果 , 如果噪声区域与我们想要修改的 Grad-CAM 位置重叠 , 我们就能够成功修改热图 。 图 13 还显示 , 如果噪声区域与目标 Grad-CAM 区域不相交 , 则 Grad-CAM 优化无法实现视觉相似性或与之等效的最终收敛损失 。 这些实验表明 , 局部噪声只会影响相应的 Grad-CAM 区域 , 同时表明不可能发生错误方向的攻击 。

文章图片

图 13. 计算每个输入上标签 “toaster” 的 Grad-CAM 。 第一行显示叠加在狗图像上的对抗性补丁的 Grad-CAM 输出 。 第二行为使用梯度扰动再现的 Grad-CAM 输出 。 第三行显示 , 如果补丁位于目标热图附近 , 仍然可以生成类似的热图 。 第四行显示 , 如果不能在目标 Grad-CAM 位置上附加干扰噪声 , 则无法直接影响 Grad-CAM 输出

2)类别建议

类别建议模块是使用选择性搜索(Selective search)和一个根据包含 ROI 池化层的原始网络修改后得到的建议网络 。 选择性搜索是一种传统的图像处理算法 , 它使用基于图形的方法根据颜色、形状、纹理和大小分割图像 。 与 Faster-RCNN 中的网络生成建议机制不同 , 选择性搜索中不存在会被攻击者扰乱的梯度成分 , 也不存在会严重限制攻击者攻击机制的会污染的训练过程 。 本文的选择性搜索算法还设计用于捕获对手类别以外的类别建议 , 攻击者将无法影响对手区域以外的选择性搜索结果 。 此外 , 由于我们的建议网络使用原始网络权重 , 因此不会在原始网络和建议网络之间产生不同的行为 。 最后 , 攻击者攻击网络类别建议过程的动机是有限的 , 因为成功的攻击将破坏攻击检测的准确性 , 而不是破坏整个过程 。 由此 , 作者得出结论:类别建议机制是鲁棒的 , 因为各个组件的属性会共同抵抗扰动或污染攻击 。

3)攻击分类

最后 , 通过分析攻击分类的鲁棒性 , 作者针对决策过程进行了实验论证 。 本文的分类过程没有使用梯度下降方法进行训练 , 这就避免了使用梯度扰动来误导分类的可能性 。 本文使用的阈值是根据可信数据集 X、X 误导概率和 X 平均置信度确定的二维数据点 。 其中 , X 平均置信度利用模式 s 来计算 。

推荐阅读

- 识别|外卖界又一黑科技 饿了么计划2022年覆盖100000顶智能头盔

- 语言识别|AI技术,让我们“听”懂聋人

- AI财经社|美团公布共享单车指纹解锁专利,网友调侃称期待人脸识别解锁

- Huawei|传大众与华为成立合资自动驾驶技术公司 回应称现阶段没有可以确认的消息

- 视点·观察|如何避免社交电商以“经销之名”行“传销之实”

- 模式|华为拍摄月亮专利获授权:可自动识别月亮并对焦

- 广西|秒级核验通行,广西机场推广刷身份证自动核验健康码

- 澎湃新闻|如何避免社交电商以“经销之名”行“传销之实”

- IT|达拉斯希望成为福特下一个自动驾驶汽车工厂的所在地

- 界面新闻|华为月亮拍摄专利获授权,可自动识别月亮并对焦