作者: 王树朋

本周要跟大家分享一篇来自TechBeat社区的 优质好文 。

图像/视频增强在手机端的应用非常多 , 但是基于深度学习的画质增强方法却往往难以真正的落地 , 这其中原因有二:(1) 模型过大 , 导致计算复杂度、内存占用高;(2) 输入图像分辨率过大 , 往往输入1K , 甚至更高 。 该文从模型的超轻量角度出发 , 提出了一种超轻量型的模型 , 这无疑为相应方法的真正落地提供了一个强大的Baseline 。

文章图片

Abstract

轻量型超分网络对于真实场景应用极为重要 , 尽管已有诸多基于深度学习的方法在图像超分领域取得前所未有的成功 , 但是它们存在高内存占用、高计算量问题 , 这严重阻碍了其在真实场景的应用问题 。

为解决上述问题 , 作者提出一种Multi-Attentive Feature Fusion Super Resolution Network (MAFFSRN) , 它由所提出的Feature Fusion Groups (FFGs) 构成 , 每个FFG包含多个所提Multi-Attention Block (MAB) , 每个MAB采用多注意力机制精炼与提取特征 。

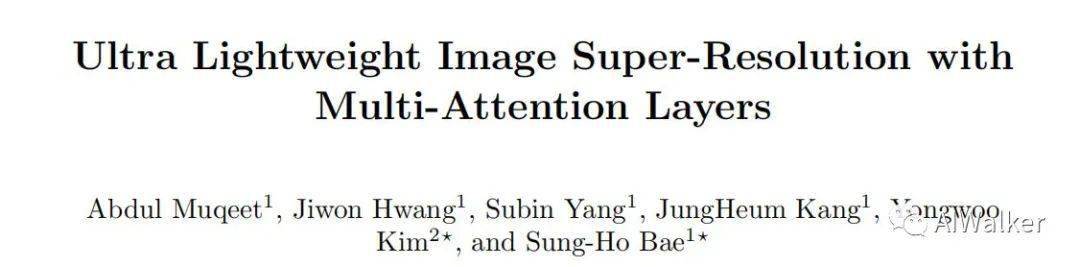

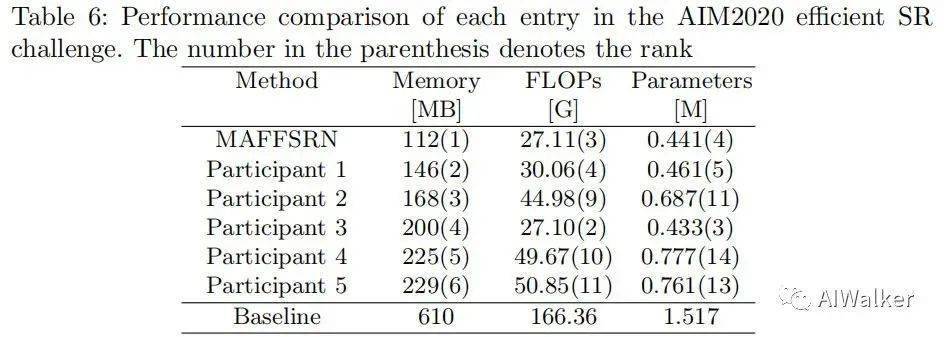

最后 , 作者通过充分的实验证实了所提方法的SOTA性能 , 并获得AIM20 Efficient SR竞赛的内存占用赛道第一 , FLOPs第三 , 参数量第四的成绩 。 下图给出了所提方法与其他SOTA超分方法在PSNR与FLOP方面的对比 。

【超轻量|超轻量型超分网络MAFFSRN: 助力真实场景应用落地】

文章图片

Comparison

该文主要贡献包含以下几点:

- 提出一种超轻量型超分网络 , 它由BFF、MAB、CEA等模块构成;

- 所提方法取得了AIM20超分竞赛内存占用第一、FLOP第三、参数量第四的成绩;

- 与其他SOTA方法在多个尺度进行了充分的定量与定性对比分析 。

文章图片

Framework

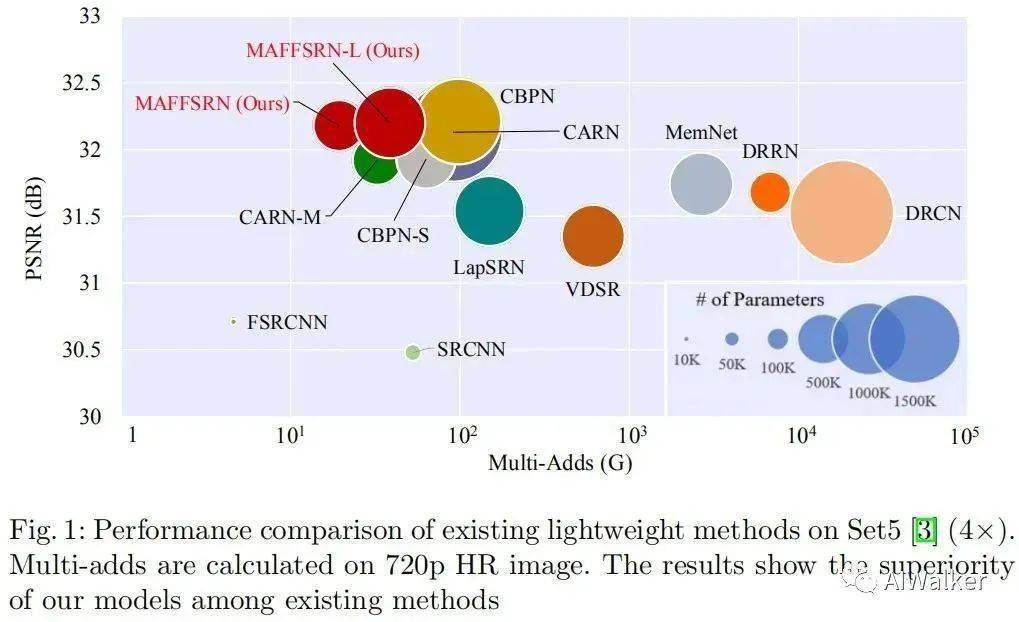

上图给出了所提方法的整体网络框架图 , 很明显它是VDSR类型的网络架构 。 MAFFSRN包含多个FFG模块 , 与多尺度上采样模块 。 MAFFSRN首先采用一个Conv提取特征 , 然后采用多个FFG进行特征精炼与增强 , 最后采用多尺度上采样模块进行超分得到残差图 , 最后与bicubic结果相加得到最终的超分结果 。 (注:作者认为该网络结构属于RDN系列 , 但从笔者角度来看应当属于VDSR系列 。 )

对于给定输入低分辨率图像 , 浅层特征提取可以描述如下:

接下来 , 就是采用多个FFG对浅层特征进行精炼与曾倩过来 , 该过程可以描述为:

最后的多尺度重建过程可以描述如下:

上面对该文所提MAFFSRN进行概括性介绍 , 下面就要对其中的一些关键性模块进行更为充分的介绍与分析 。

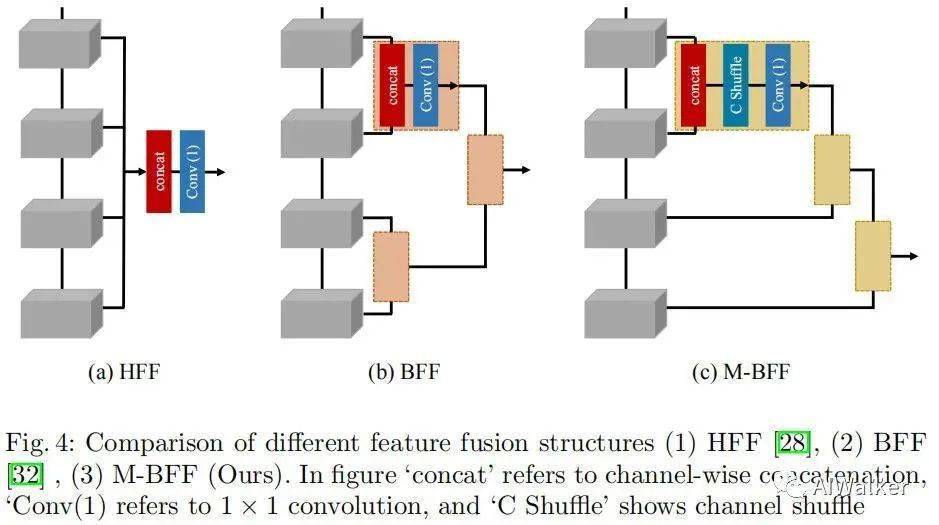

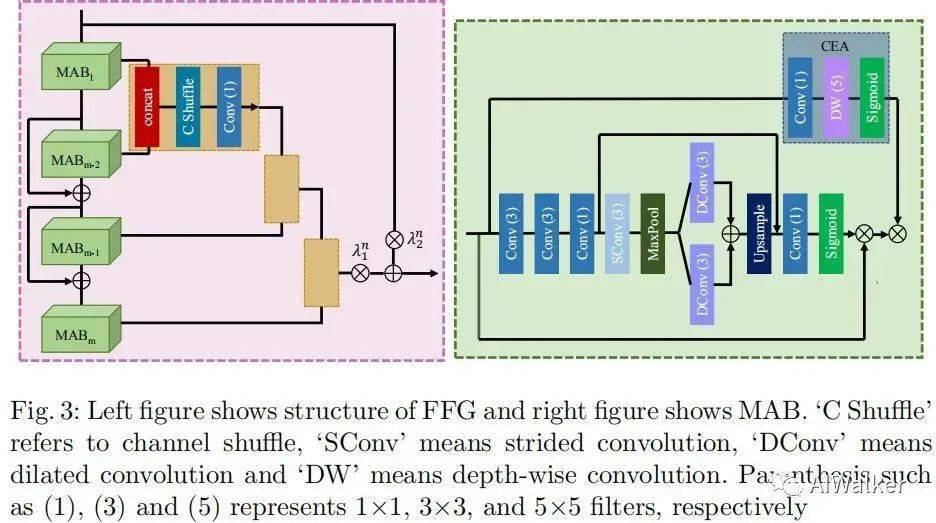

FFG

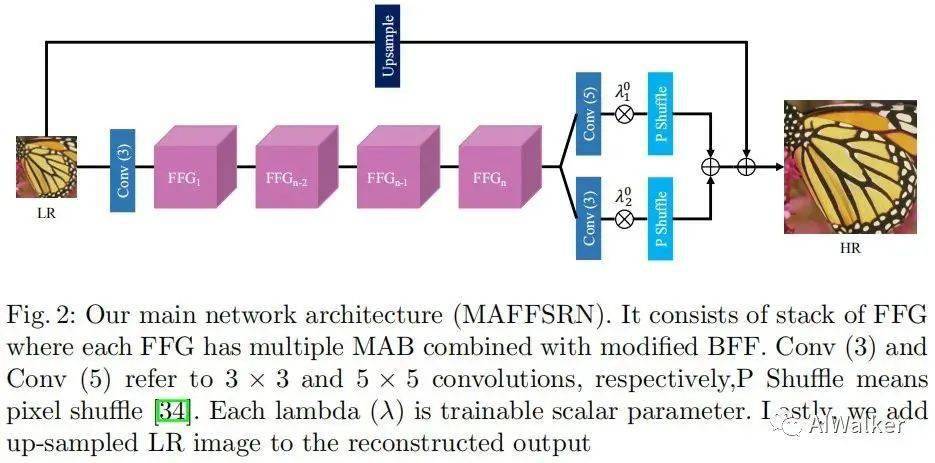

我们首先来介绍一个FFG这个模块 , 它有多个MAB模块 (见下一小节内容) 构成 。 下图给出了几种形式的MAB组合模式 , HFF可以算作“一次性”融合模式 , BFF可以视作“分组”融合模式 , 而该文所提用到的则是第三种“渐进式”融合模式 , 见下图c 。

文章图片

FFG

在BFF特征融合模式中 , 先对特征进行分组 , 相邻组特征通过concat方式进行融合得到组数减半的特征 , 顺次进行特征融合;而在所提M-BFF特征融合模式中 , 则是采用“渐进式”的特征融合 , 也就是说先融合两组 , 融合结果在于第三组融合 , 依次进行融合得到最终的融合特征 。

受启发与ShuffleNet , 在特征融合时作者引入了“通道置换”思想混合不同通道的信息 , 同时起到降低计算量目的 。 最后的特征输出则是采用自适应残差学习的方式 , 见MAB部分的示意图 。

注:请恕笔者知识面浅薄 , 未能搞懂这里的“通道置换”到底有什么作用 。 在ShuffleNet一文中 , “通道置换”是为了进行组卷积时组间“信息交互” , 而这里后接的是1x1卷积 , 好像不需要进行这个操作 , 就算进行了这个操作 , 在推理阶段它也可以和后接的1x1卷积合并 , 懵逼状态 。

MAB

文章图片

MAB

前面已经介绍了FFG , 那么接下来就要介绍一下MAB模块了 , 见上图右 (注:上图左即为FFG的更详细示意图) 。

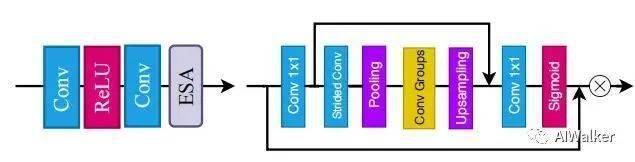

MAB着重强调了通道注意力机制的重要性 , RFANet一文中同时引入了空域注意力机制与通道注意力机制 (称之为ESA) , 见下图 。

文章图片

ESA

该文作者在ESA的基础上进行了引入扩张卷积 (不仅可以降低内存占用 , 同时可以提升感受野 , 进而提升模型性能) 使其更高效 , 更进一步 , 作者将多个扩张卷积的输出结果通过Add方式融合以消除Gridding问题 。 与此同时 , 作者引入了另一种高效的注意力机制 (cost-efficient attention, CEA) 用于精炼输入特征 , CEA有1x1卷积与depthwise卷积构成 。

Experiments

“实验是检验真理的唯一标准” , 所以为更好的说明所提方法的有效性 , 作者进行了充分的实验对比分析 。

在模型配置方面 , 作者提供了两个模型:MAFFSRN与MAFFSRN-L 。 MAFFSRN包含4个FFG , 每个FFG包含4个MAB;MAFFSRN-L则包含8个FFG , 每个FFG包含4个MAB 。 在MAB中 , 1x1卷积的通道下降因子为4 , stride卷积的stride=3 , 扩展卷积的因子分别为1和2 , 自适应参数初始化为0.5 , 网络中的通道数默认为32 。

在训练数据方面 , 作者还采用DIV2K进行模型训练 , 验证集则为Set5、Set14、B100、Urban100等 。

在训练超分方面 , 作者采用了AdamP优化器 , 初始学习率为 , 每200epoch折半 , 合计训练1000epoch;数据增强方法为标准方法 (随机镜像、随机旋转) , Batch=16 , 输入块大小为 。

在度量准则方面 , 作者采用YCbCr空间Y通道的PSNR与SSIM;同时作者还对比了参数量、FLOPs等 。

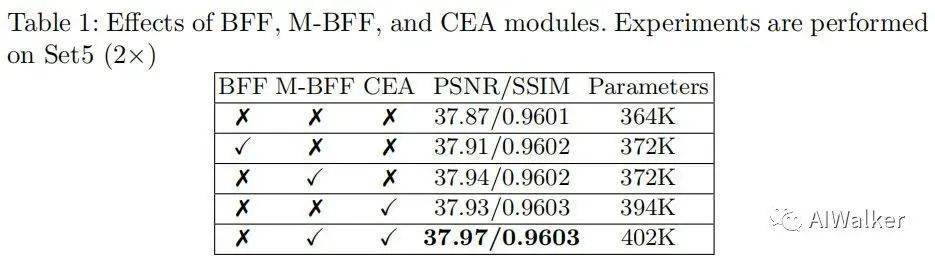

我们首先来看一下消融实验结果对比 , 下表给出了不同特征融合模式的性能对比 。

文章图片

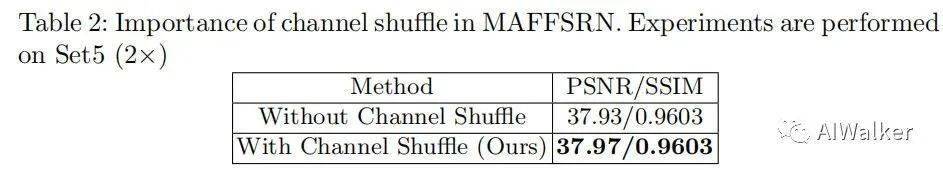

下表给出了“通道置换”添加前后的性能对比 。

文章图片

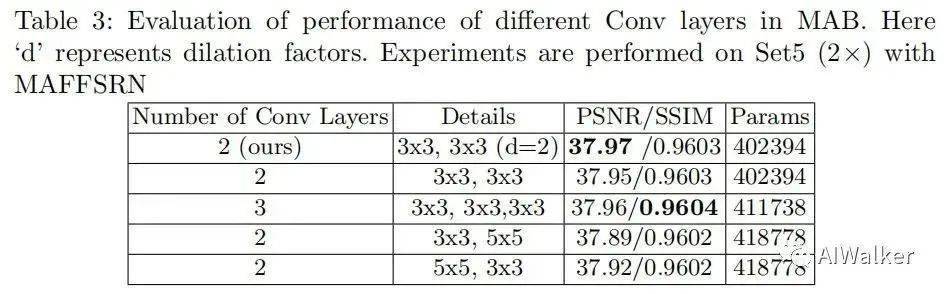

下表给出了MAB中不同卷积的性能对比 。

文章图片

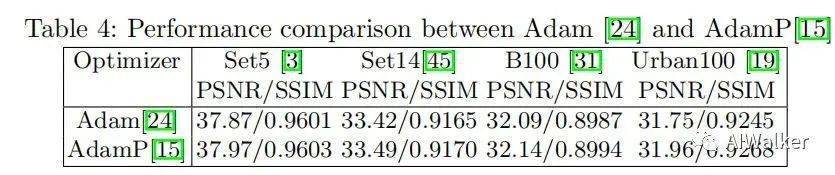

下表给出了不同优化器训练模型的性能对比 。

文章图片

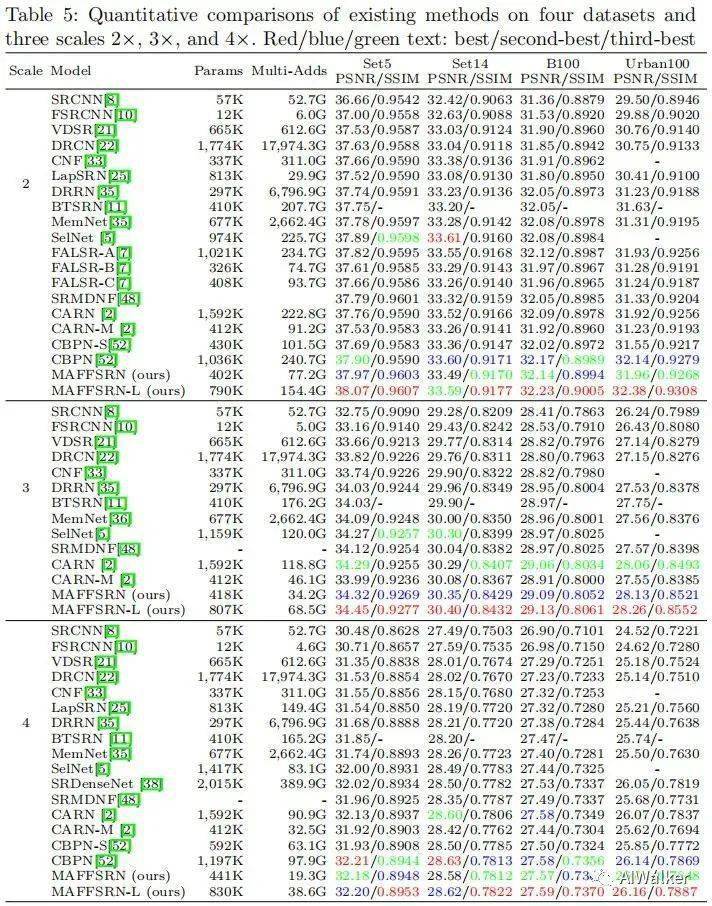

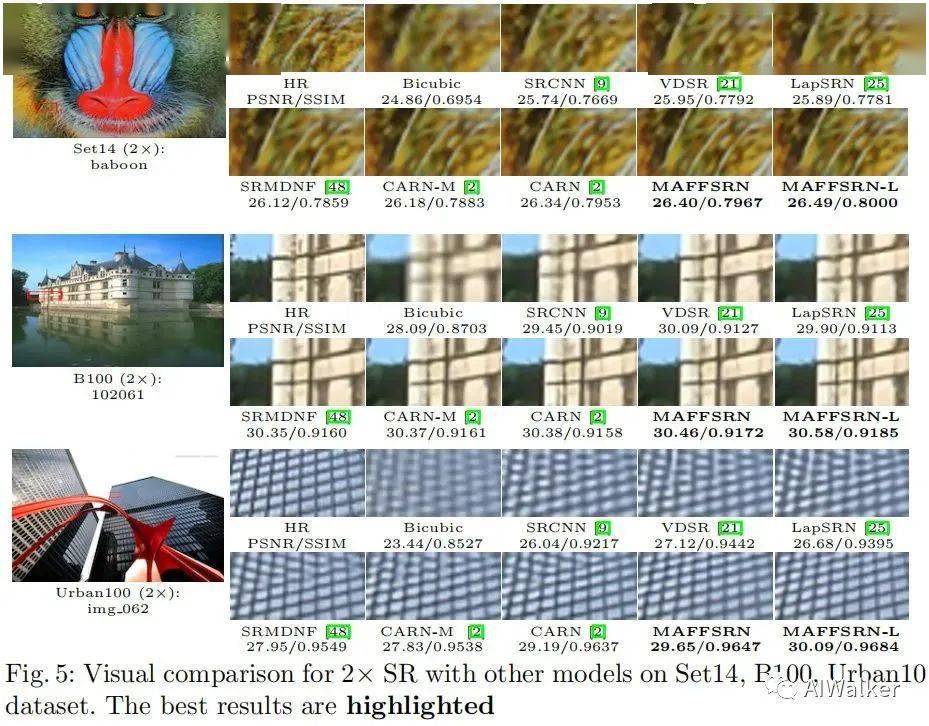

接下来就是重点了 , 下表给出了所提方法与其他SOTA方法的性能对比与视觉效果对比 。

文章图片

文章图片

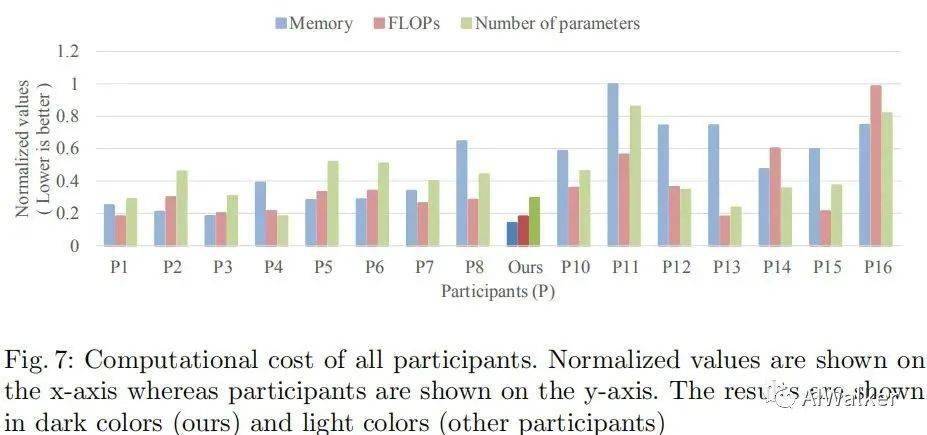

下面给出了AIM20超分竞赛的结果对比 , 注:该竞赛要求超分的指标与ESRGAN (PSNR导向训练) 在DIV2K相当的前提下尽可能降低计算量、参数量以及内存占用 。 内存占用采用torch.cuda.max_memory_allocated进行测试 , FLOPs则是在输入测试 。 所提方法在DIV2K验证集上的平均速度为0.104s (100张平均) 。

文章图片

文章图片

-The End-

推荐阅读

- 浦峰|冬奥纪实8k超高清试验频道开播,冬奥结束后转入常态化运转

- 技术|“2”类医械有重大进展:神经介入产品井喷、基因测序弯道超车

- 影像|iQOO 9 系列预热:首发三星 GN5 传感器,150° 鱼眼超广角

- 重大进展|“2”类医械有重大进展:神经介入产品井喷、基因测序弯道超车

- IT|全球每日新增确诊病例首超100万例 世卫:两大毒株正掀起“疫情海啸”

- Tesla|特斯拉回应“保费暴涨”:平均涨幅约10% 高性能车型不超20%

- 硬件|Intel 11代酷睿4核15瓦超迷你平台 仅有信用卡大小

- Tesla|网传特斯拉等新能源汽车保费上涨超50% 多家车险公司回应不实

- 中国|超燃!100秒回顾中国航天2021精彩瞬间

- AI|商汤科技上市首日收涨超7% 市值约1375亿港元