机器之心报道

编辑:陈萍、蛋酱

通用近似定理很好地解释了为什么神经网络能工作以及为什么它们经常不起作用 。此前 , 图灵奖得主、深度学习先驱 Yann LeCun 的一条推文引来众多网友的讨论 。

在该推文中 , LeCun 表示:「深度学习并不像你想象的那么令人印象深刻 , 因为它仅仅是通过曲线拟合产生的插值结果 。 但在高维空间中 , 不存在插值这样的情况 。 在高维空间中 , 一切都是外推 。 」

文章图片

而 LeCun 转发的内容来自哈佛认知科学家 Steven Pinker 的一条推文 , Pinker 表示:「 通用近似定理很好地解释了为什么神经网络能工作以及为什么它们经常不起作用 。 只有理解了 Andre Ye 的通用近似定理 , 你才能理解神经网络 。 」

文章图片

Pinker 所提到的 Andre Ye , 正是接下来要介绍《You Don’t Understand Neural Networks Until You Understand the Universal Approximation Theorem》文章的作者 。 虽然该文章是去年的 , 但在理解神经网络方面起到非常重要的作用 。

在人工神经网络的数学理论中 ,通用近似定理(或称万能近似定理)指出人工神经网络近似任意函数的能力 。 通常此定理所指的神经网络为前馈神经网络 , 并且被近似的目标函数通常为输入输出都在欧几里得空间的连续函数 。 但亦有研究将此定理扩展至其他类型的神经网络 , 如卷积神经网络、放射状基底函数网络、或其他特殊神经网络 。

此定理意味着神经网络可以用来近似任意的复杂函数 , 并且可以达到任意近似精准度 。 但它并没有告诉我们如何选择神经网络参数(权重、神经元数量、神经层层数等等)来达到我们想近似的目标函数 。

1989 年 , George Cybenko 最早提出并证明了单一隐藏层、任意宽度、并使用 S 函数作为激励函数的前馈神经网络的通用近似定理 。 两年后 1991 年 , Kurt Hornik 研究发现 , 激活函数的选择不是关键 , 前馈神经网络的多层神经层及多神经元架构才是使神经网络有成为通用逼近器的关键

最重要的是 , 该定理解释了为什么神经网络似乎表现得如此聪明 。 理解它是发展对神经网络深刻理解的关键一步 。

更深层次的探索

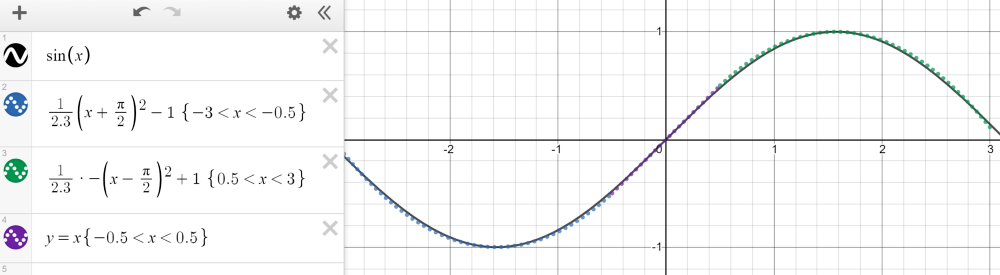

紧凑(有限、封闭)集合上的任何连续函数都可以用分段函数逼近 。 以 - 3 和 3 之间的正弦波为例 , 它可以用三个函数来近似——两个二次函数和一个线性函数 , 如下图所示 。

文章图片

推荐阅读

- 星链|石豪:在太空,马斯克和美国当局是如何作恶的

- 建设|这一次,我们用SASE为教育信息化建设保驾护航

- 生活|气笑了,这APP的年度报告是在嘲讽我吧

- 历史|科普:詹姆斯·韦布空间望远镜——探索宇宙历史的“深空巨镜”

- 空间|(科技)科普:詹姆斯·韦布空间望远镜——探索宇宙历史的“深空巨镜”

- 精度|将建模速率提升10倍,消费级3D扫描仪Magic Swift在2021高交会大显“身手”

- 最新消息|世界单体容量最大漂浮式光伏电站在德州并网发电

- 公司|科思科技:正在加速推进智能无线电基带处理芯片的研发

- 测试|图森未来完成全球首次无人驾驶重卡在公开道路的全无人化测试

- Monarch|消息称微软Win11 2022重大更新将在明年夏天到来