Apple|A15仿生芯片幕后故事:历经四年研发 多个团队跨部门合作( 二 )

也就是说,苹果公司为了呈现今天的 A15 仿生芯片,几个团队从 2017 年就开始着手准备 。

文章图片

Bob 补充说 ,Tim 的芯片团队不仅服务于下一代新品,他们甚至在产品发布会前一个礼拜还在讨论某些功能 。从这个细节也能印证苹果公司这种研发方式的灵活度 。

Android旗舰芯片研发时间也是两年多,但手机终端厂商适配时间只有约 3-4 月 。终端厂商因为不是自己掌控全程,可能导致终端与芯片不完美匹配,或者无法释放芯片的全部能力,能耗控制不那么精准 。另外,为了照顾更多样的Android终端,芯片也不得不做一些取舍 。

此前,很多评测媒体对 A15 仿生芯片做了相应测试,相比上代,它的 CPU 计算核心部份日常负载下的“能耗比”显着提升 ,5 核 GPU 的极限性能则较上代提升了 40%, 功耗反倒上代低 。

这路数跟前几代 A 系列芯片一致,苹果一直在通过芯片+系统等多种方式,优化芯片的能耗比,也就是用更少的电做更多事 。

谈体验 而不是谈跑分

回到今年装在 iPhone 13 系列上的 A15 仿生芯片,在评测这款手机时候,我们已经看到它的性能跑分依旧凶猛,尤其 GPU 部分 。但其实 Bob 在这次谈话中更想说的是,硬件性能固然重要,但对苹果来说,用户体验才是更重要的事 。

也正是因此,我们才能看到 iPhone 13 Pro 系列性能更强了 ,ProMotion 高刷来了,续航却更长了 ;iPadOS 15 中的翻译 App, 可以实现实时自动翻译对话,甚至第三方的 App, 可以用 AI 分析人类的动作,从而教人打网球 。

那是 A15 和整合在其中 CPU,GPU,NPU, 以及 iOS 15 在一同发挥作用 。在处理这些的同时,苹果还要严守自己的隐私原则,尽量让数据在本地处理,而不是发送到云端去 。

文章图片

文章图片

最能证明多个部分合作的体验是 iPhone 13 系列的“电影效果模式”,它让非专业拍摄者通过一台非专业设备,获得了以往专业人士才能做出的变焦操作 。

文章图片

电影效果的背后,是 A15 仿生芯片的强大计算能力作后盾,它强到足以一边拍杜比视界 HDR 视频,一边用 AI 能力去实时理解该对焦给谁,并把焦外做虚化处理 。还能把景深信息保留下来进行二次处理 。

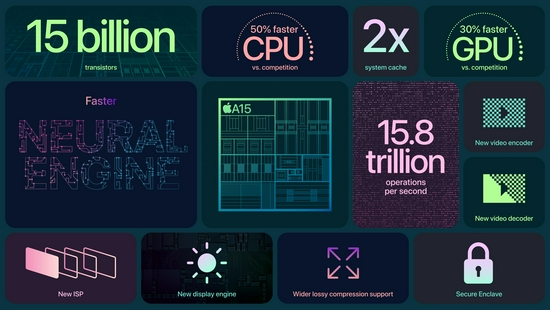

焦距变化的背后,是 A15 芯片内 150 亿颗晶体管和手机影像系统的共同参与,也是苹果芯片研发团队,影像团队,和系统等多个团队合作的结晶 。

推荐阅读

- Apple|苹果高管解读AirPods 3代技术细节 暗示蓝牙带宽可能成为瓶颈

- Apple|摩根大通分析师:交货时间来看iPhone 13系列已达供需平衡

- Apple|法官称苹果零售店搜包和解协议虽不完美,但可继续进行

- Apple|苹果希望手机/平板设备能正面为其他设备无线充电

- Apple|新专利显示 苹果计划用光学传感器取代手表的数码表冠

- Apple|苹果放弃英特尔的决定在今年得到了回报

- Apple|韩国要求苹果和Google删除"玩游戏赚钱"的游戏类别

- 苹果|苹果目标达成,Apple Music中的9000万首歌曲已全部达到无损标准

- Music|小米 12 系列正式发布 / Apple Music 发布 2021 音乐回忆歌单 / 斗鱼年度十大弹幕出炉

- Apple|2001年PowerBook G4和2021年MacBook Pro对比:很相似