Jiangmen

From: Google 编译: T.R

目前训练稀疏网络最流行的方法是 剪枝方法 , 但这种方法目前存在两个主要局限 。 为此 , 来自 谷歌的研究人员提出了一种名为 RigL的算法来训练稀疏神经网络 , 相比于现有从稠密到稀疏的训练方法 , 这种方法不会牺牲精度 , 并且在训练过程中可以安全才能够真正得到保障!

文章图片

https://proceedings.icml.cc/static/paper_files/icml/2020/287-Paper.pdf

代码链接:

https://github.com/google-research/rigl.

现代神经网络通常含有非常丰富的冗余结构 , 所以人们常常可以在不损失精度的情况下去除大部分的连接结构 。 与稠密网络相比这种稀疏的结构具有更高的参数与计算效率 , 同时还能在某些情况下大幅减少推理时间 。

目前训练稀疏网络最流行的方法是 剪枝方法,(从稀疏到稠密训练)通常先需要训练稠密的模型 , 而后通过剪断/忽略其中的一些连接来对模型进行稀疏化 。 但这种方法目前存在两个主要的局限:

1. 稀疏模型的大小会受到最大可训练稠密模型的限制 。 虽然稀疏模型具有更高的参数效率 , 但却无法利用剪枝方法训练出比最大可能的稠密模型更精确的结果;

2. 剪枝方法效率较低 , 主要是由于需要对大量为零的或者是在推理时为零的参数进行十分庞大的计算 。 目前还不清楚最好的剪枝算法是否是稀疏模型性能的上限 。

文章图片

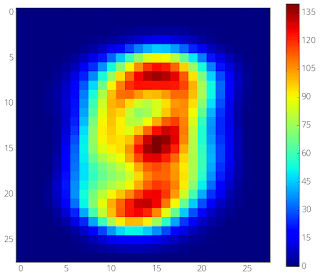

下图显示了在训练感知机过程中 , 基于RigL方法训练的稀疏网络会将连接的注意力逐渐聚焦于图像的中心 , 而忽略边缘部分信息较少像素区域 。

文章图片

文章图片

第一张图是MNIST的平均图像;另一张图为稀疏性为98%下两层MLP的连接训练结果 。 可以看到从随机掩膜开始 , 模型的注意力逐渐向中间区域的像素集中 。 具有信息较少的边缘区域逐渐被具有像素信息较多的中心区域连接所替代 。

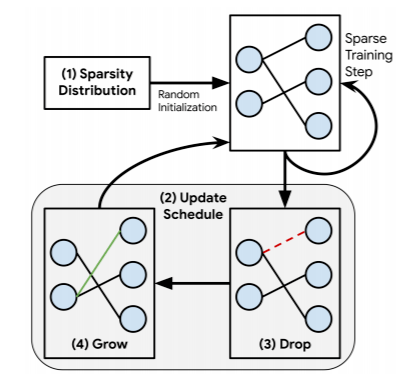

RigL算法概览

RigL方法首先利用随机稀疏拓扑结构来初始化网络 。 在规则的间隔下算法将具有最小权重的连接部分去除 , 这种策略对于模型整体的性能影响非常小 。 RigL算法随后利用瞬态梯度来激活新的连接 , 在无需历史梯度信息的情况下为为网络动态地构建新的有效连接 。

在连接更新后 , 模型继续进行训练并移去权重最小的连接 , 激活梯度最大的新连接 , 整个过程不断迭代循环 。 之所以激活梯度最大的新连接是因为模型认为损失在梯度最大的连接上下降最快 。

文章图片

RigL从随机初始化的稀疏连接网络开始 , 随后剪除弱激活连接;随后计算瞬态梯度寻找最大的梯度连接作为新的激活连接 , 整个过程周而复始 , 直到达到要求的精度 。

性能测评

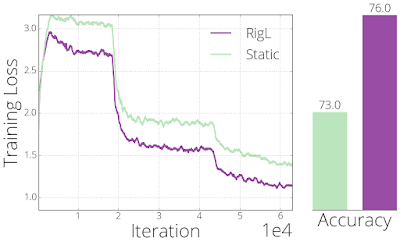

通过在训练过程中动态地改变连接 , RigL可以帮助优化器获得更好的模型结构与参数 。 为了展示算法的性能 , 研究人员从一个精度较差的模型开始利用RigL重新训练 。 下面的结果展示了模型在迭代过程获得了比静态训练(稀疏网络中的连接保持不变)更好的结果 。

文章图片

RigL和静态方法从相同的静态稀疏模型开始训练 , 训练过程损失和最终的精度如上图所示 。

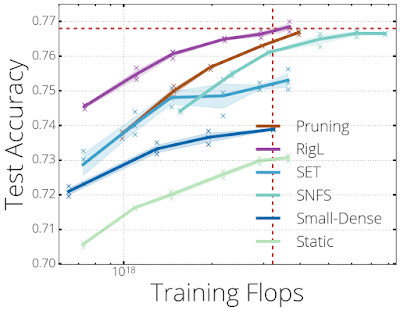

下图汇总了不同训练方法在训练80%稀疏性的ResNet-50网络架构时的性能 。 RigL不仅与最近提出的稀疏训练方法SET和SNFS进行了比较 , 同时还与静态训练模型、小的稠密模型以及剪枝方法进行了比较 。

文章图片

80%稀疏的ResNet-50模型的训练精度 。 图中的虚线显示了训练标准ResNet-50模型时所需的计算量 。 RigL小五倍参数的情况下取得了与标准ResNet-50的性能 。

其中SNFS和剪枝方法由于会训练较大的网络模型或存储很多的梯度信息 , 需要很密集的计算资源;整体上来讲 , 所有的方法随着训练周期的增加都显示出了明显的性能提升 , 因此研究人员将训练的周期数增加到原来的五倍来更好的对各个算法的性能进行比较 。

【大幅提升|超越剪枝方法,谷歌提出的新算法RigL大幅提升稀疏模型训练】与先前的研究结果类似 , 在固定稀疏性下(静态)训练的模型可以获得与剪枝方法相比拟的推理精度 。 而训练相同参数的小稠密模型则会得到比静态训练的稀疏模型更好的结果 , 但却会比动态稀疏网络的性能要差 。

结果显示 , 虽然SET算法超过了小稠密模型的结果 , 但其精度在75%附近饱和 , 这显示了随机产生新连接方法的局限性 。 而使用梯度信息生成新连接的RigL和SNFS方法则获得了更好的精度 , 其中RigL在更少的计算资源和内存容量下取得了最高的精度 。

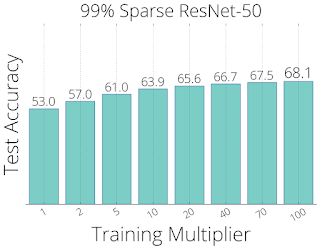

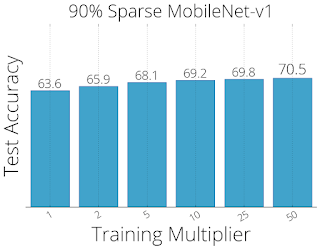

为了观测更长训练下模型的性能趋势 , 研究人员比较了更长训练周期下的性能 。 在1~100倍训练周期下RigL算法会使得模型的性能稳步提升 , 在99%稀疏ResNet-50模型上取得了68.7% 的Top-1精度 , 在90%稀疏的MobileNet-v1上取得了70.55%的Top-1精度 。 未来的研究将集中于在更少的训练下取得相同的性能表现 。

文章图片

文章图片

RigL方法下 , 模型性能随着训练周期的提升 。

包括99%稀疏性的ResNet-50 (上) 和90%稀疏性的MobileNets-v1 (下) 架构 。

未来的研究方向

目前的研究表明 , RigL可以在下面三种场景中发挥重要的作用:

1. 改善需要部署的稀疏模型的精度;

2. 在有限的训练周期下改善大型稀疏模型的精度;

3. 与稀疏性的本质结合起来 , 使得超大型稀疏模型的训练成为可能 。

但目前由于软硬件的限制 , 研究人员还没有对第三个场景进行充分地探索 。 随着新型硬件对于稀疏性支持的不断提升 , RigL方法将能有效释放出这些硬件的计算潜力 , 实现更为快速、准确、高效的模型训练 。

▼

推荐阅读

- 精度|将建模速率提升10倍,消费级3D扫描仪Magic Swift在2021高交会大显“身手”

- 识别|天津滨海机场RFID行李全流程跟踪系统完成建设 行李标签识别成功率可提升至99%

- IT|南非研究显示两剂强生新冠疫苗可大幅降低Omicron导致的住院

- 周鸿祎|网络安全行业应提升数字安全认知

- 手机|1千亿让小米超越苹果?别被雷军的障眼法,忽悠了

- 曾学忠|小米手机部总裁曾学忠:希望明年与光弘科技完成智能手机4000万台目标 将引入高端和旗舰项目提升合作规模

- 安全风险|网络安全行业应提升数字安全认知

- 增加到|首儿所互联网医院服务能力再提升,线上号源增加到每日1500个

- 保障|《“十四五”原材料工业发展规划》印发 提升原材料工业保障引领制造业能力

- 技术|山西:提升科技水平 打造高速公路出行“安全卫士”