文章图片

Taskflow 使用示意图

项目地址:https://github.com/PaddlePaddle/PaddleNLP/blob/develop/docs/model_zoo/taskflow.md

预训练时代的微调新范式应用:三行代码提升小样本学习效果

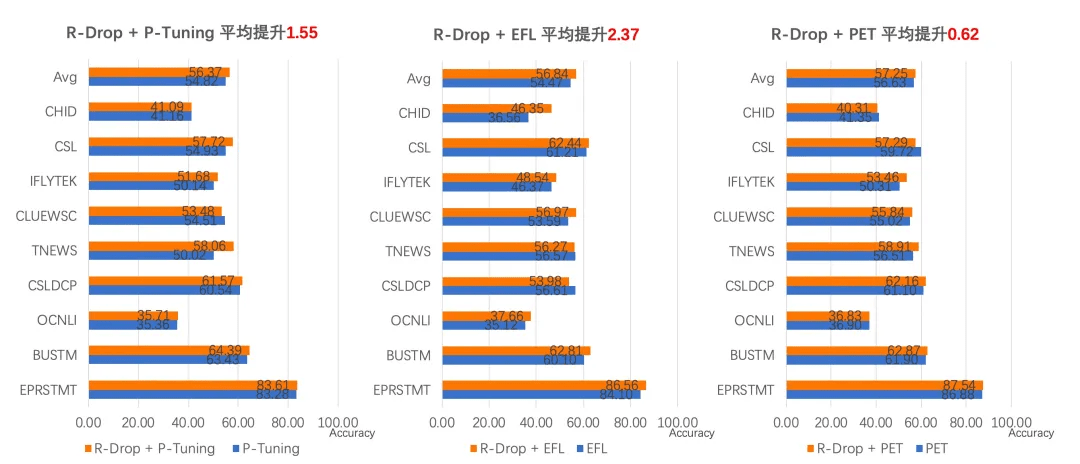

Few-Shot Learning(以下简称 FSL)是机器学习的一个子领域 。 在仅有少数监督样本的情况下 , 训练得到强泛化能力的模型 , 实现对新数据的分类 。

结合最新的 Prompt Tuning 的思想 , PaddleNLP 中集成了三大前沿 FSL 算法:

- EFL(Entailment as Few-Shot Learner)[1] , 将 NLP Fine-tune 任务统一转换为二分类的文本蕴含任务;

- PET(Pattern-Exploiting Training)[2] , 通过人工构建模板 , 将分类任务转成完形填空任务;

- P-Tuning[3]:自动构建模板 , 将模版的构建转化为连续参数优化问题 。

文章图片

项目地址:https://github.com/PaddlePaddle/PaddleNLP/tree/develop/examples/few_shot

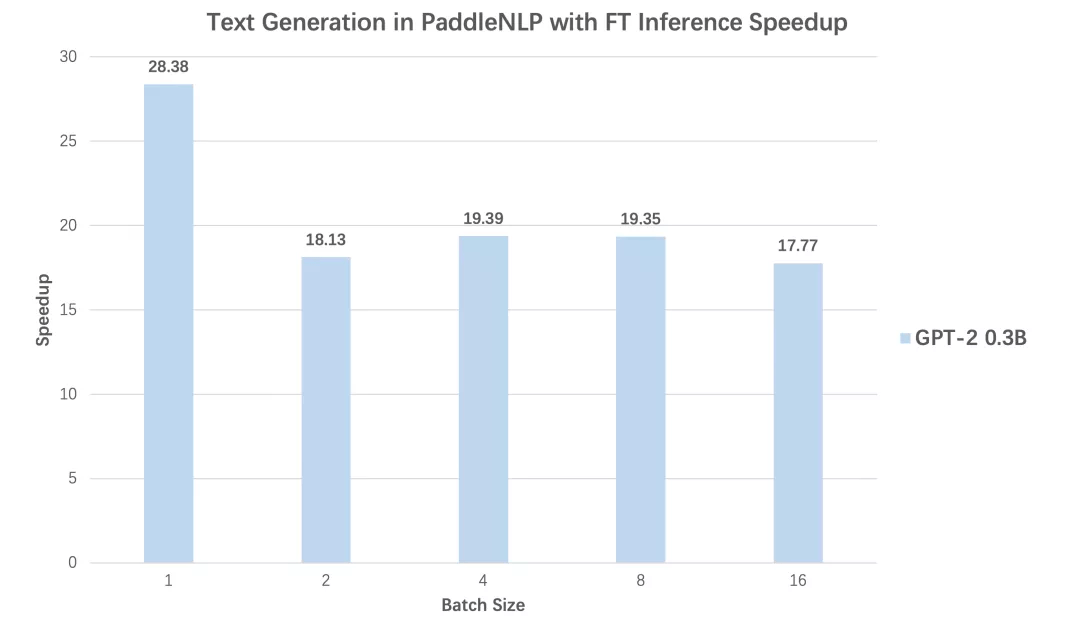

高性能预测加速:文本生成场景高达 28 倍加速效果

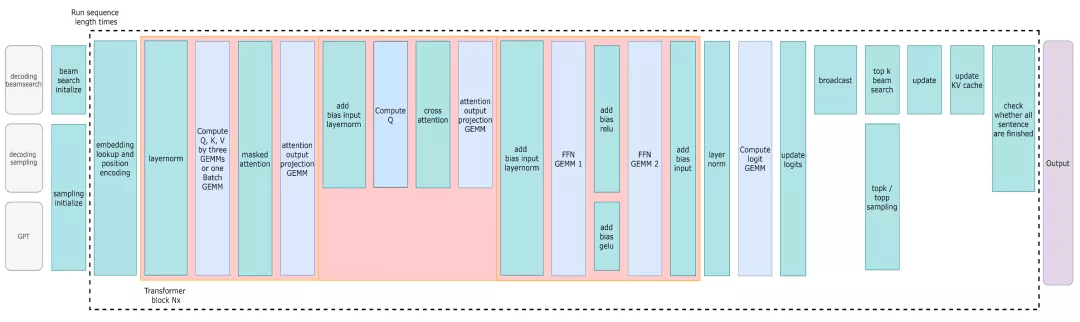

PaddleNLP 与 NVDIA 强强联合 , 以 FasterTransformer[5] 为基础 , 提供了 Faster 系列的推理 API , 重点拓展了更多主流网络结构适配与解码策略支持 。 同时结合飞桨核心框架 2.1 版本全新的自定义 OP 的功能 , 提供了与飞桨框架无缝衔接的使用体验 。

文章图片

FasterTransformer Decoding Workflow

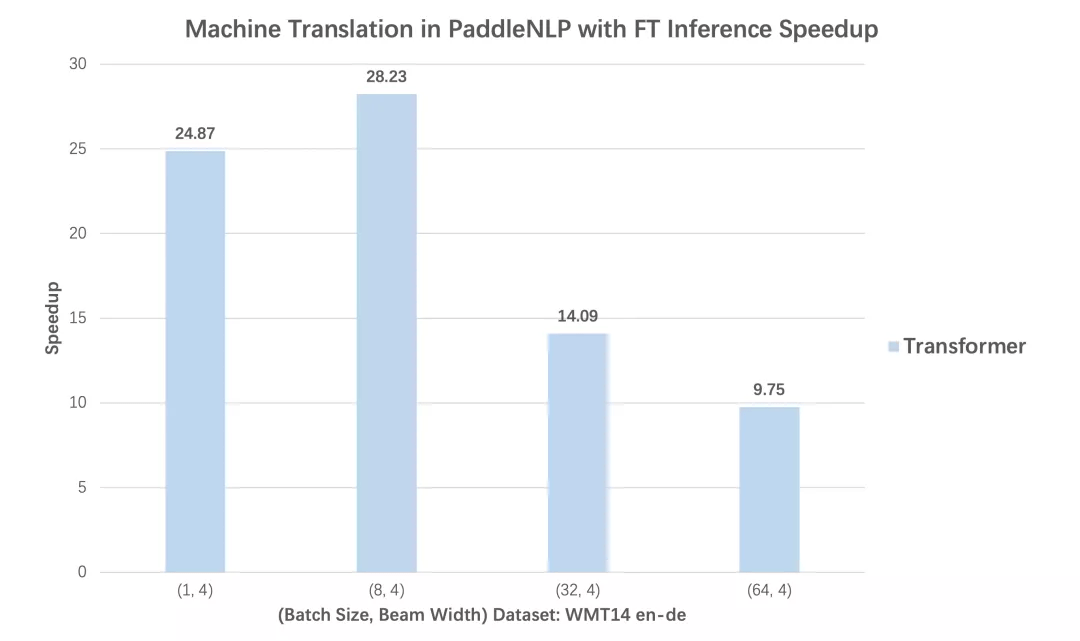

(1) 大幅提升生成任务的推理能力

在 Transformer 机器翻译、GPT 文本生成两个任务中 , 分别对比使用动态图版本的性能和内置 Faster 系列的推理 API 后 , 不同 batch size 下预测性能加速比 , 从对比数据可以看到无论 Transformer 还是 GPT , 均可得到高达 28 倍推理速度提升!

文章图片

文章图片

文章图片

文章图片

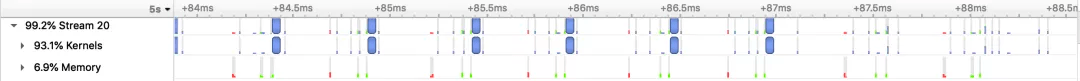

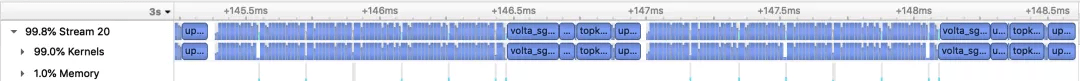

PaddleNLP Transformer 翻译模型加速优化前后的Nsight Profling 对比图

(2)支持丰富的经典解码策略

推荐阅读

- 雷军|和雷军一起开箱,领取小米12「专属指南」

- 最新消息|被骂“从未见过如此厚颜无耻之书” 中华书局回应称即日下架

- 骁龙|骁龙8旗舰驯龙大战一触即发,“大师”和“高手”谁更厉害?

- 视点·观察|互联网人身险新规过渡期即将结束 17家险企明年起暂别该业务

- 画质|AMD RSR 分辨率缩放技术曝光:基于 FSR,无需游戏适配即可使用

- 电子商务|无需扫码、碰一碰即可完成支付 数字人民币硬钱包充电桩项目启动!

- 模型|2022前展望大模型的未来,周志华、唐杰、杨红霞这些大咖怎么看?

- 视频|中国移动联盟优品店炸裂来袭!惊喜一触即发!戳视频一探究竟!

- 花湖|亚洲第一个专业货运机场!花湖机场即将启航

- 产品|青岛有“礼”正式揭秘:华为首家青岛旗舰店开业在即