丰色 发自 凹非寺

量子位 报道 | 公众号 QbitAI

很多3D人体模型都很强大 , 但总是难免“裸奔” 。

像要创造出真正的人类“化身”模型 , 衣服和头发不可或缺 。

但这些元素的精确3D数据非常稀少 , 还很难获得 。

文章图片

来自三星AI中心(莫斯科)等团队的技术人员一直致力于此方面的研究 , 最终他们开发出这样一个模型:

生成的3D人 , 穿着原本的衣服、发量发型也都毫无保留地呈现 。

乍一看 , “跟真人似的” 。

更棒的是 , 无需模特示范 , 模型还可以“举一反三” , 摆出各种POSE!

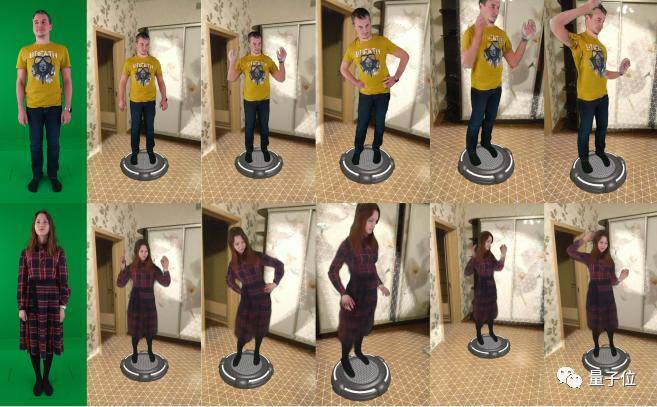

效果是这样子的:

文章图片

该模型被命名为StylePeople 。

来看看具体怎么搞的吧!

神经装扮模型(The neural dressing model)

其实 , 不止是“裸奔” , 很多三维人体模型还很“死板”:模特摆什么姿势模型就跟着摆什么 。

就像此前 , 利用隐函数来生成的三维人体模型能够高度还原模特的着装和发型了 , 但是人物姿势依然不够变通 , 只能从原模特的几个特定视角生成 。

ps.也是该团队的研究成果

所以在为3D人体模型还原衣服颜色、褶皱和发型的同时 , 也要保证人物的姿势可以“举一反三” 。

为此研究人员采用将多边形实体网格建模与神经纹理相结合的方法 。

多边形网格负责控制和建模粗糙的人体几何姿势 , 而神经渲染负责添加衣服和头发 。

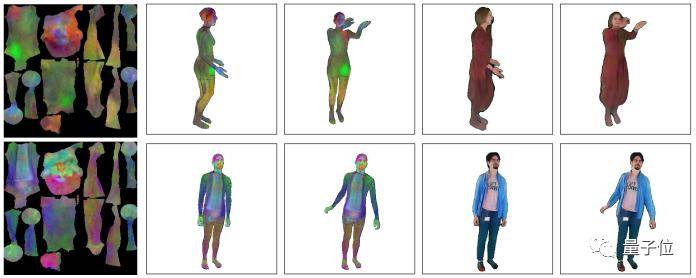

首先他们设计了一个神经装扮模型(The neural dressing model) , 该模型结合了可变形网格建模与神经渲染 , 如下图所示 。

文章图片

最左列表示被可视化的前三个PCA组件 。

第2、3列为在用SMPL-X建模的人体网格上叠加“人型化身”的纹理(texture) 。

第4、5列为使用渲染网络光栅化渲染出的结果 。

可以优雅地处理出宽松的衣服和长头发以及复杂的穿衣结构!

接下来 , 基于上面的神经装扮模型 , 研究人员造出能生成“Fullbody”的3D人体模型 。

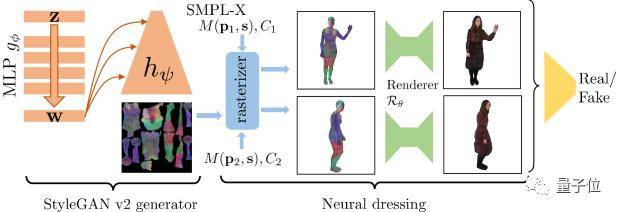

最终的生成架构是StyleGANv2和神经装扮的结合 。

StyleGAN部分使用反向传播算法生成神经纹理 , 然后将其叠加在SMPL-X网格上 , 并使用神经渲染器进行渲染 。

文章图片

在对抗性学习中 , 判别器将每一对图像看为同一个人 。

提高了视频和少量图像生成3D人类模型的技术水平

在对神经装扮这一方法的效果验证中 , 研究人员首先评估了基于视频素材的3D模型生成结果 。

效果如文章开头所展示的图像 , 左边是示例源帧 , 其余的图像是左边视频人物的“化身” 。 在简单的增强现实程序做的背景下 , 呈现出了模特先前并没有摆过的各种姿势 。

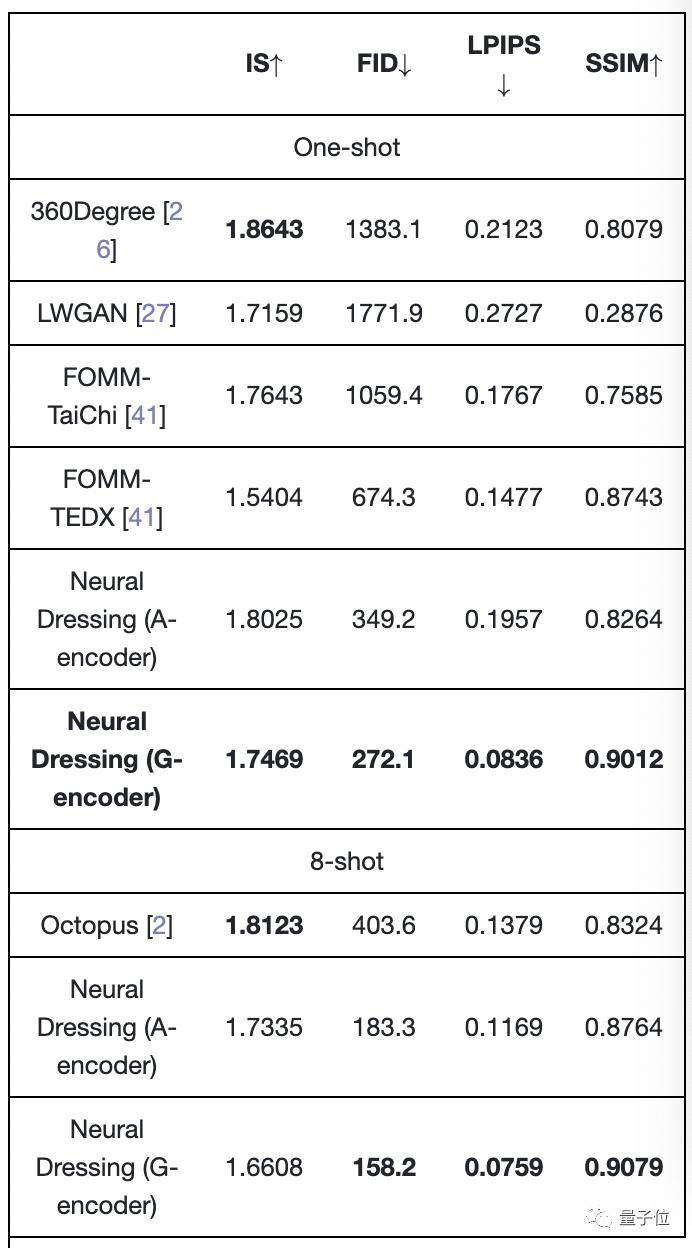

接下来 , 对基于小样本图像素材的神经装扮效果进行评估 。

研究人员使用仅两个人的People Snapshot数据集将他们的神经装扮方法与其他各种方法(如360Degree等 , 见表)进行比较 。

衡量生成的模型质量的指标包括LPIPS(感知相似度)、SSIM(结构相似性)、FID(真实样本与生成样本在特征空间之间的距离)、和IS(清晰度与多样性得分) 。

结果显示了他们的方法在所有指标上都占有优势 ,

除了IS以外 , 但影响不大 , 因为它与视觉质量的相关性最小 。

文章图片

最后 , 该团队表示 , 他们这个模型的生成效果(如下图)仍然受到目前样本数据规模和质量的限制 , 今后工作重点是提高该模型的数据利用率 。

文章图片

有兴趣的同学可以持续关注该团队的研究进展 。

参考链接:

[1]https://arxiv.org/abs/2104.08363

— 完 —

本文系网易新闻?网易号特色内容激励计划签约账号【量子位】原创内容 , 未经账号授权 , 禁止随意转载 。

_原题《差点以为是本人!这个3D人体生成模型厉害了 , 还能自己改POSE》

【StyleGANv|差点以为是本人,这个3D人体生成模型厉害了,还能自己改POSE】阅读原文

推荐阅读

- 网络化|工信部:2025年建成500个以上智能制造示范工厂

- 视点·观察|科技股连年上涨势头难以持续:或已透支未来涨幅

- 华依|中信证券:惯性导航有望成为L3及以上自动驾驶的标配产品

- IT|以色列正式批准开放第四剂新冠疫苗接种 限免疫力低下人群

- 系统验证|以技术革新加速芯片创新效率,EDA软件集成版PNDebug正式发布

- Tesla|特斯拉Model Y保费何以一夜暴增80%?

- 领域|上海市电子信息产业“十四五”规划:以集成电路为核心先导

- 数字化|70%规模以上制造业企业到2025年将实现数字化、网络化

- |南安市司法局凝初心践使命 以民为本做实人民调解

- 数据|中标 | 数梦工场以数字新动能助力科技优鄂