选自Facebook AI

机器之心编译

编辑:小舟、陈萍

Facebook AI 提出新型视频理解架构:完全基于Transformer , 无需卷积 , 训练速度快、计算成本低 。【时间|无需卷积,完全基于Transformer的首个视频理解架构出炉】TimeSformer 是首个完全基于 Transformer 的视频架构 。 近年来 , Transformer 已成为自然语言处理(NLP)领域中许多应用的主导方法 , 包括机器翻译、通用语言理解等 。

TimeSformer 在一些具有挑战性的动作识别基准(包括 Kinetics-400 动作识别数据集)上实现了最佳的性能 。 此外 , 与 3D 卷积神经网络(CNN)相比 , TimeSformer 的训练速度大约快了 3 倍 , 而推断所需的计算量不足其十分之一 。

论文链接:

https://arxiv.org/pdf/2102.05095.pdf

此外 , TimeSformer 的可扩展性使得在更长的视频片段上训练更大的模型成为可能 。 这为 AI 系统理解视频中更复杂的人类行为打开了大门 , 对需要理解人类复杂行为的 AI 应用来说是极为有益的 。

文章图片

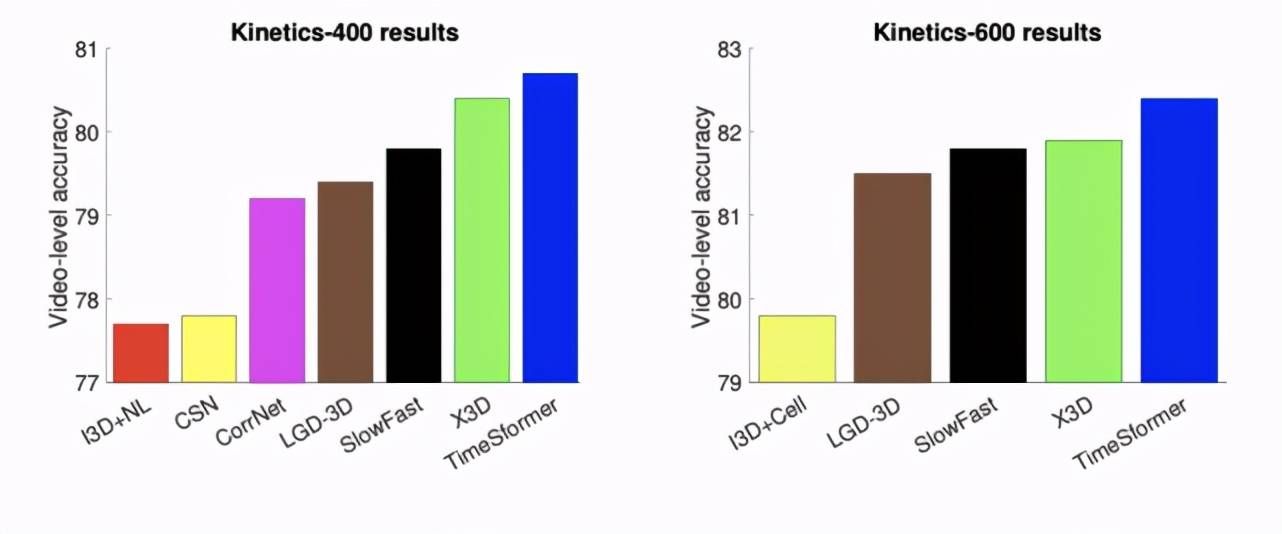

在 Kinetics-400(左) 和 Kinetics-600(右) 两个动作识别基准上 , TimeSformer 与当前具有 SOTA 性能的 3D 卷积神经网络的视频分类准确率比较结果 。 TimeSformer 在这两个数据集上都达到了最优的准确率 。

TimeSformer:全新的视频理解架构

传统的视频分类模型利用了 3D 卷积滤波器 。 然而这样的滤波器在捕获局部时空区域内的短程模式方面是有效的 , 但是它们不能对超出其接受域的时空依赖关系进行建模 。

TimeSformer 仅建立在 Transformer 模型中使用的自注意力机制上 , 这使得捕获整个视频的时空依赖关系成为可能 。 为了将 Transformer 应用到视频中 , 该模型将输入视频解释为从每个帧中提取的图像 patch 的时间 - 空间序列 。

这种格式类似于 NLP 中使用的格式 , 在 NLP 中 , Transformer 将句子视为从每个单词中计算出的特征向量序列 。 正如 NLP Transformer 通过将每个单词与句子中的其他单词进行比较来推断其含义一样 , 该模型通过显式地将每个 patch 与视频中的其他 patch 进行比较来捕获每个 patch 的含义 。 这也是所谓的自注意力机制 , 这使得捕获相邻 patch 之间的短程依赖性以及远距离 patch 之间的远程关联成为可能 。

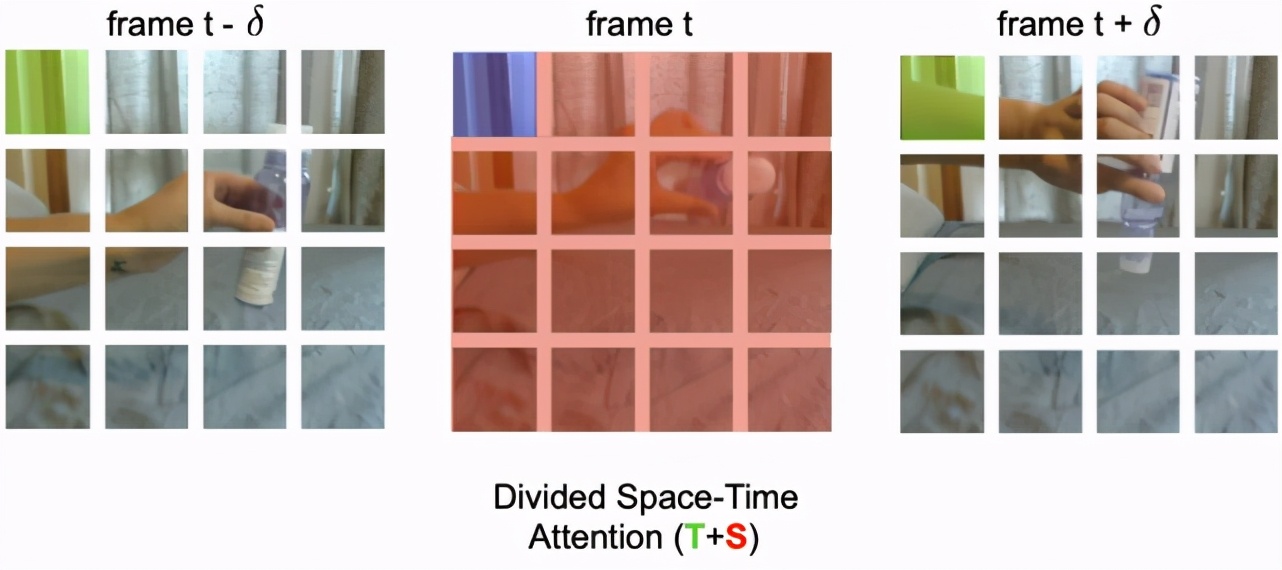

传统的 3D 卷积神经网络计算成本比较高昂 , 因为它们需要在视频中所有的空间 - 时间位置上使用大量的滤波器 。 而 TimeSformer 具有较低的计算成本 , 因为它:(1)将视频分解成一组不重叠的 patch;(2)采用自注意力 , 避免对所有 patch 对进行详尽的比较 。 研究者将此方案称为分割空间 - 时间注意力 , 其思想是依次应用时间注意力和空间注意力 。

当使用时间注意力时 , 每个 patch(例如在下图中 , 蓝色的正方形)只与其他帧中相同空间位置的 patch(绿色正方形)进行比较 。 如果视频包含 T 帧 , 则每个 patch 只进行 T 次时间上的比较 。 当使用空间注意力时 , 每个 patch 仅与同一帧内的 patch(红色 patch)进行比较 。

因此 , 如果 N 是每帧中的 patch 数 , 则分割空间 - 时间注意力只对每个 patch 执行一共(T+N)次比较 , 而不是联合空间 - 时间注意力的方法所需的(T×N)次比较 。 此外 , 该研究发现与联合空间 - 时间注意力相比 , 分割空间 - 时间注意力不仅更有效 , 而且更准确 。

文章图片

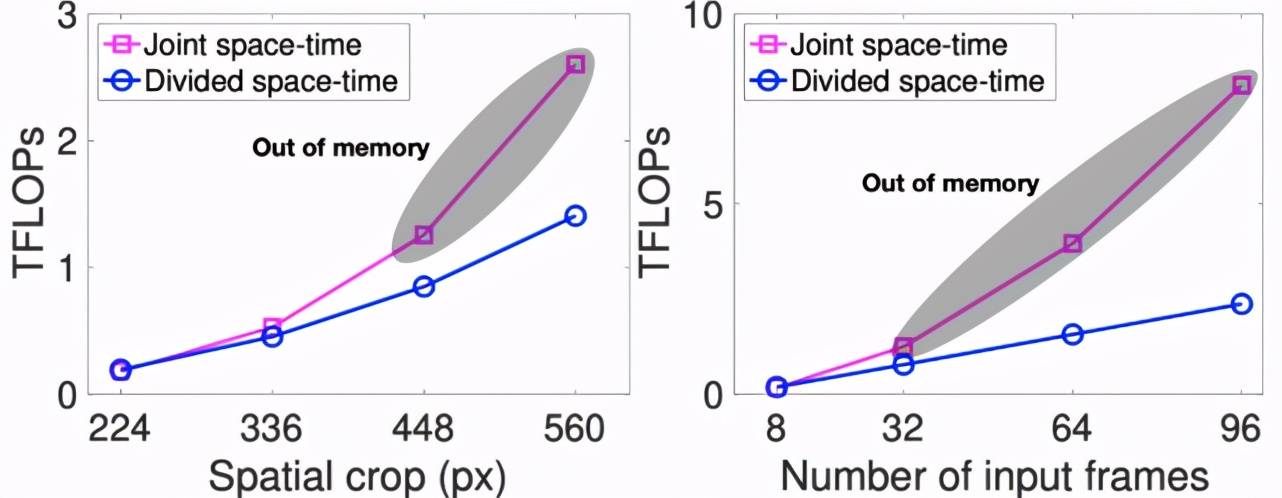

TimeSformer 的可扩展性让它能够在极长的片段(例如 , 102 秒时长的 96 帧序列)上运行 , 以执行超长程时间建模 , 这明显不同于当前的 3D CNN 。 后者仅限于处理至多几秒钟的片段 。 而识别长时间活动是一种重要需求 。

例如 , 假设有一个制作法式吐司的视频 。 一次分析几秒钟的 AI 模型可能会识别出一些原子动作(例如打鸡蛋或将牛奶倒入碗中) 。 但对每个单独动作进行分类 , 对于分类复杂活动是远远不够的 。 TimeSformer 则可以在更长的时间范围内分析视频 , 从而揭示出原子动作之间明确的依赖关系(例如将牛奶和已经打好的鸡蛋混合) 。

文章图片

TimeSformer 的高效让在高空间分辨率(例如高达 560x560 像素的帧)和长视频(包括高达 96 帧)上训练模型成为可能 。

文章图片

上图展示了由 TimeSformer 学习的自注意力热图的可视化 。 第一行是原始帧 , 第二行通过自注意力给出的视频分类重要性来加权每个像素的颜色(被认为不重要的像素会变暗) 。 TimeSformer 学习参与视频中的相关区域 , 以执行复杂的时空推理 。

促进更多领域的发展

为了训练视频理解模型 , 目前最好的 3D CNN 只能使用几秒长的视频片段 。 使用 TimeSformer 可以在更长的视频片段(长达几分钟)上进行训练 。 这可能会极大地促进研究工作 , 以教会机器理解视频中复杂的长动作 。 对于许多旨在了解人类行为的 AI 应用程序(例如 AI 助手)而言 , 这是重要的一步 。

此外 , TimeSformer 的低推理成本是迈向未来实时视频处理应用的重要一步 , 例如 AR/VR , 以及为可穿戴摄像机视频提供服务的智能助手 。 研究者相信该方法的成本降低将使更多的研究人员致力于解决视频分析问题 , 从而加快该领域的研究进展 。

推荐阅读

- AMD|AMD 350亿美元收购赛灵思交易完成时间推迟 预计明年一季度完成

- Apple|摩根大通分析师:交货时间来看iPhone 13系列已达供需平衡

- Microsoft|微软推Viva Insights插件 定时邮件可根据时区推荐发送时间

- 认识论|管理好时间,是最有价值的投资

- 新闻|(暂不发)2021新闻年历|你不停翻着新闻,寻找时间的故事

- Intel|英特尔正为Linux 5.17准备PFRUT:升级系统固件无需重启

- 画质|AMD RSR 分辨率缩放技术曝光:基于 FSR,无需游戏适配即可使用

- 电子商务|无需扫码、碰一碰即可完成支付 数字人民币硬钱包充电桩项目启动!

- 发射|我国成功发射天绘-4卫星

- 流程|哈尔滨机场“全流程自助安检”来了,过检时间或将缩短一半